Verantwortungsvoller Einsatz von KI in der Unternehmensführung

CDR-Ansätze müssen autonome KI-Systeme abdecken

Alexander Huber

Erschienen 21.03.2022

Ein beispielhafter Blick in die Zukunft

Künstliche Intelligenz

Erklärbare KI

Unternehmerische Verantwortung für den KI-Einsatz

Auswirkungen von KI in der Unternehmensführung

Fazit

KI wird zukünftig die Unternehmensführung durchdringen und auch den Kern autonomer Unternehmen bilden. Das Verständnis der Unternehmensleitung für KI-getriebene Strategieentscheidungen ist eingeschränkt, denn KI ist selten dafür konzipiert, Entscheidungen zu erklären. Ist ein Veto der Unternehmensleitung überhaupt möglich, wenn sie an KI-Entscheidungen gebunden ist? Corporate Digital Responsibility (CDR) zielt auf einen Handlungs- und Entscheidungsrahmen, der das Spannungsfeld zwischen Optimierung, Compliance und Integrität ausbalanciert.

Die Digitalisierung hielt bereits vor vielen Jahren Einzug in die Praxis. Zunächst mit der digitalen Abbildung bisher analoger Daten, über deren Verarbeitung bis zu Prozessen, die unstrukturierte, sich ändernde und fehlerbehaftete Massendaten für Maschinen verständlich machen [1]. Trotz steigender Komplexität lag den Verarbeitungsvorgängen in der Praxis eine regelbasierte Ausführung zugrunde. Das heißt: Menschen entscheiden sich für eindeutige Regeln bzw. Wenn-Dann-Beziehungen und programmieren diese. Insofern galt zumindest in der Praxis lange die in den 1960er Jahren aufgestellte Behauptung von Peter Drucker: „Der Computer trifft keine Entscheidungen, er führt nur Befehle aus. Er ist ein totaler Idiot“ [2].

Seit neuerem schreiben Menschen Computerprogramme und Algorithmen in einer Art, dass diese selbstständig lernend in der Lage sind, eigene Regeln aufzustellen und selbst Entscheidungen zu fällen. Diese Regeln werden nicht vom Menschen kodifiziert, sondern von der IT-Anwendung erlernt. Die IT-Anwendung entscheidet sich also nicht notwendigerweise in einer für den Menschen vorhersehbaren Art und Weise.

Ein beispielhafter Blick in die Zukunft

An einem warmen Herbsttag steht ein Lieferant völlig unerwartet mit dem 10-fachen der sonst üblichen Bestellmenge von Sensoren vor der Tür eines fiktiven technischen Geräteherstellers. Der Mann im Wareneingang ruft verwundert seine Chefin an, und diese den Zulieferer. Alle rätseln, warum diese übertrieben hohe Menge geliefert wurde. Aber: die IT-Anwendung hat rechtsgültig beim Lieferanten bestellt und dieser nimmt die Sensoren nicht zurück.

Es bleibt völlig unklar, warum diese hohe Menge bestellt wurde, bis drei Wochen später im monatlichen Purchase-Council des Unternehmens vor weltweit auftretenden Lieferengpässen bei Sensoren und den damit verbundenen Preiserhöhungen gewarnt wird. Im Nachgang zeigt sich, dass am Tag vor der Bestellung mehrere Analysten Warnungen vor weltweit auftretenden Lieferengpässen bei Sensoren ausgesprochen hatten. Weitere Analysen zeigen ergänzende Faktoren auf, die die Entscheidung der IT-Anwendung beeinflussten: Das Demand-Forecasting zeigte, dass sich die Nachfrage nach Produkten, in denen der Sensor verbaut wird, stark erhöht. Gleichzeitig ist der Krankenstand im Unternehmen unerwartet niedrig, sodass mehr Menschen als sonst um diese Jahreszeit in der Produktion verfügbar sind. Eine gute Stimmung, und damit Produktivität, unter der Belegschaft lässt sich auch aufgrund der von der IT-Anwendung ausgewerteten LinkedIn-Einträge und ‑Vernetzungen der Mitarbeiter sowie deren Beiträge in ihren öffentlich zugänglichen Instagram-Profilen vermuten. Wie auch immer. Am Ende hat das IT-System die optimale Menge bestellt, auch wenn dies anfangs nicht klar war. Alle sind sich einig: Schwein gehabt.

Was wäre passiert, wenn die Einkaufschefin frühzeitig Wind von der ihr unerklärlich großen Bestellung bekommen hätte? Sie hätte die Entscheidung der IT-Anwendung nicht nachvollziehen können und die Bestellung daraufhin manuell auf ein normales Maß reduziert. Das Unternehmen verliert daraufhin Millionen. Gerade als Mitglied des Management-Teams hat sie aber die Pflicht, alle ihr zur Verfügung stehenden Informationen zu nutzen, um optimale Entscheidungen zu treffen. Der Aufsichtsrat des Unternehmens weisen daraufhin den Vorstand an, die Einkaufschefin persönlich für die Preiserhöhungen in Haftung zu nehmen.

Zukünftig wird sich die Einkaufschefin aus der Verantwortungslinie nehmen. Sie hat gelernt: Die IT-Anwendung ist eine Autorität, deren Entscheidungen, seien sie noch so unverständlich, sie sich beugen muss.

Möglicherweise treffen IT-Anwendungen in manchen Situationen bessere Entscheidungen als Menschen. Möglicherweise aber auch schlechtere und diskriminierende. Je intelligenter die IT-Anwendungen werden, desto schwieriger fällt es Menschen, ihre Entscheidungen zu verstehen. Die IT-Anwendungen sind nicht dafür konzipiert, ihre Entscheidungen zu erklären. Gibt es dennoch ein Recht auf Erklärungen, die Menschen verstehen? Sind die Menschen an Entscheidungen gebunden, die sie nicht verstehen? Wer haftet, wenn IT-Anwendungen schlechte Entscheidungen fällen und Menschen verpflichtet sind, diese umzusetzen?

Wie werden sich Unternehmen technisch, organisatorisch und dadurch auch kulturell verändern? Welche Auswirkungen gibt es auf Mitarbeiter, Führung, Agilität und Effizienz? Was muss passieren damit sich die digitale Entwicklung verantwortungsvoll vollzieht? Wie lässt sich das Spannungsfeld zwischen Optimierung, Compliance und Integrität in der Balance halten?

Künstliche Intelligenz

Intelligenz wird nicht mehr nur als weitgehend angeborene, von äußeren Faktoren und Erfahrungen unbeeinflusste, analytische Fähigkeit betrachtet [3], [4]. Heute verstehen wir Intelligenz als Zusammenfallen von analytischer, kreativer (Fähigkeit zur unkonventionellen Problemlösung) und praktischer Intelligenz (Fähigkeit zur Anpassung an die Umwelt). Intelligenz ist insgesamt also die Fähigkeit, gesetzte Ziele zu erreichen, sich dabei an geänderte Bedingungen anzupassen und dadurch zu lernen [3], [5].

Unter Künstlicher Intelligenz (KI) werden Methoden und Anwendungen verstanden, die den kognitiven Apparat des Menschen durch technische Methoden ersetzen. KI bedeutet vor diesem Hintergrund, die Umgebung durch Datenerfassung wahrzunehmen, aus diesen Daten zu lernen, Schlussfolgerungen abzuleiten und sich dabei flexibel an die Gegebenheiten anzupassen [4], [6].

Je nach Grad der Autonomie werden in der Regel drei verschiedene Stufen von KI-Systemen unterschieden, mit denen Fragen der Haftung und Rechenschaft eng verbunden sind [7], [8]:

1) Assistierend: Menschen sind die Entscheider. KI-Systeme unterstützen bei Aufgaben, die ein Mensch auch selbst erbringen könnte (z. B. Übersetzung). Vereinfacht wird hier auch vom Human-in-the-Loop-Ansatz gesprochen.

2) Erweitert (augmented, amplified): Menschen sind die Entscheider oder mit Vetorechten ausgestattete Beobachter. Das KI-Systeme bereitet komplexe Entscheidungen vor und führt Aufgaben durch, die vom Menschen schwer vorgenommen werden können (z. B. Vorhersagemodelle auf Basis großer Datenmengen). Das Ergebnis der maschinellen Entscheidungsfindung ist für den Menschen nicht immer nachvollziehbar. Menschen müssen sich ggf. auf die maschinelle Entscheidung verlassen, sodass dann von einer gemeinsamen Entscheidungsfindung gesprochen werden kann. Damit wird der menschzentrierte Governance-Ansatz in Unternehmen in Frage gestellt. Diese Stufe kommt dem Human-on-the-loop-Ansatz nahe: Entscheidungen werden vom Menschen überwacht.

3) Autonom: KI-Systeme entscheiden allein (Human-out-of-the-loop).

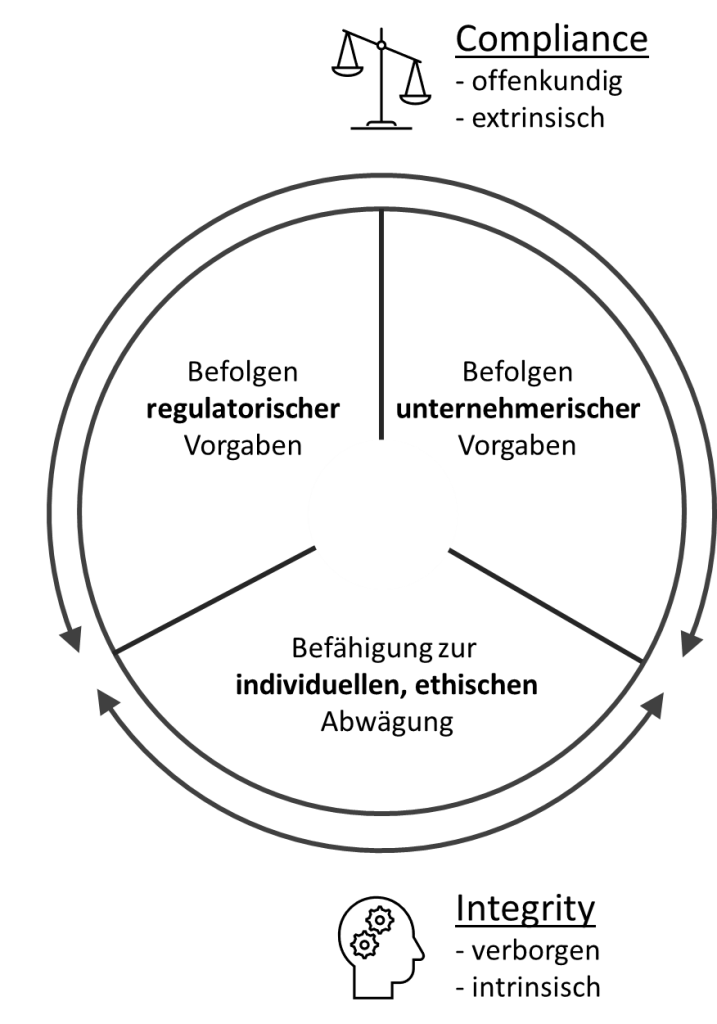

Intelligente, autonome KI-Systeme setzen dort an, wo Menschen an ihre naturgegebenen Grenzen stoßen, und brechen mit ihrer tatsächlichen – aber zumindest zugeschriebenen – Überlegenheit etablierte Machtstrukturen in Unternehmen auf. Bei einer Übertragung von Macht und Verantwortung auf KI-Systeme als Blackbox mit undurchsichtiger Funktionsweise, ist zwangsläufig die Balance zwischen extrinsischer Regeltreue (Compliance) und intrinsischer Selbststeuerung (Integrität) gefährdet [9], [10]. Naturgemäß stehen auf Algorithmen beruhende KI-Systeme den Compliance-Ansätzen deutlich näher und gefährden über Anreize und Sanktionen individuelle Autonomie, Freiheitsgrade und Integrität, die bei menschlicher Führung zwar nicht garantiert, aber doch wahrscheinlicher sind [9], [10]. Es droht eine Rückkehr zu autoritären Führungspraktiken in neuem Gewand [11].

Erklärbare KI

Wird also von Menschen erwartet, dass sie Entscheidungen von KI-Systemen vertrauen und nicht gleichzeitig zu reinen Erfüllungsgehilfen werden, müssen sie den Kern der getroffenen Entscheidungen verstehen [12]. Die Forschung zur erklärbaren KI (eXplainable AI): XAI steckt noch in den Kinderschuhen [13], wird aber wichtige Voraussetzung zur Erfüllung des Rechts auf Erklärung (s. z. B. Art. 13 DSGVO).

Automatisierte inhaltliche Erklärungen sind aber nicht nur für Vertrauensbildung, Zusammenarbeit und Feststellung von Verantwortlichkeiten relevant, sondern auch, um zu bestätigen, dass eine Entscheidung korrekt getroffen wurde. So lernen KI-Systeme manchmal, dass ihnen „Schummeln“ die Arbeit erleichtert und sie dennoch die explizit vorgegebenen Ziele erreichen: 2017 sollte ein KI-System lernen, wie es Pferde auf Bildern in Trainingsdaten erkennt. Stattdessen stellte es fest, dass es nur nach dem Copyright-Tag eines bestimmten Fotografen suchen musste, der zufälligerweise alle in den Trainingsdaten enthaltenen Pferdebilder aufgenommen hatte, statt zu lernen, ob tatsächlich ein Pferd abgebildet war [14]. So lernte die KI zwar aus den Trainingsdaten (Datenpaaren) und erfüllte die expliziten (programmierten) Ziele, kann aber nicht die impliziten, deutlich komplexeren Ziele des menschlichen Systemdesigners interpretieren.

Integration der KI in das Unternehmen

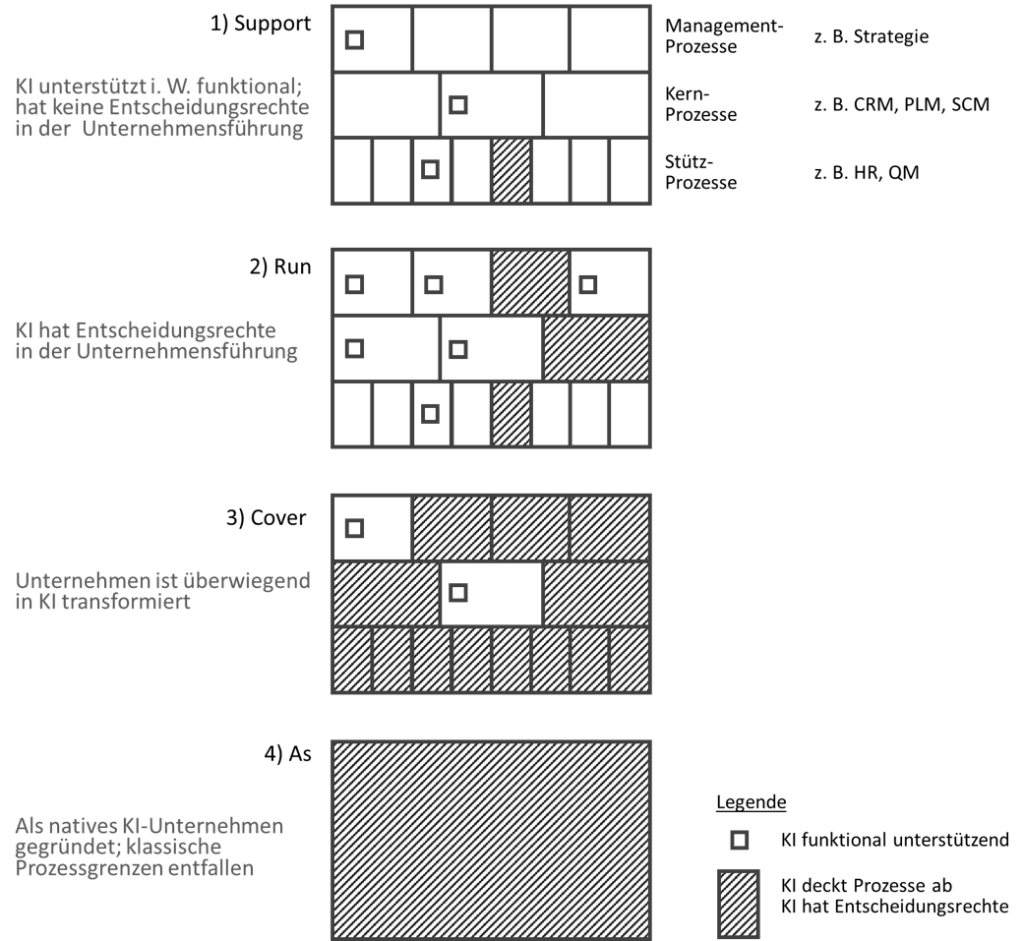

KI-Anwendungen können nun in bisher von IT wenig unterstützten Bereichen Anwendung finden (z. B. Strategische Planung), vorhandene IT-Anwendungen übergreifend steuern und so sukzessive immer weitere Unternehmensprozesse und ‑entscheidungsbereiche abdecken (s. Abbildung 1).

AI-supports-the-organization: KI unterstützt einzelne Funktionen in Support- und Kernprozessen (wie z. B. Einkauf, Produktion) und deckt einzelne Kern- und Stütz-Prozesse ab.

- AI-runs-the‑organization: Perspektivisch wird KI stärker in Management-Prozesse bzw. Unternehmensführung (z. B. Strategische Planung) integriert und zunehmend mit weiteren Entscheidungsrechten ausgestattet. Im Extremfall könnten KI-Systeme Teile der Unternehmensführung übernehmen [8].

- AI-covers-the-organization: Evolutionäre Ausbreitung der KI bis zur Abbildung vieler/aller Unternehmensprozesse auf allen Ebenen (Management-, Kern- und Stützprozessen). Menschen sind hier i. W. für Entscheidung, Erstellung und Parametrisierung von Zielen, Strategien und Algorithmen zuständig, aber nicht mehr dominierend für den operativen Ablauf, Entscheidungsfindung oder ‑umsetzung. Menschen wirken entweder an den Zielen, Strategien und Algorithmen mit oder werden Erfüllungsgehilfen, z. B. wenn Maschinen nicht zulässig sind.

- AI-as-the-organization: Letztendlich ist die Frage, inwiefern sich neue Geschäftsmodelle entwickeln, die gänzlich ohne menschliches Zutun auskommen. Dabei sind diejenigen Unternehmen im Vorteil, die sich nicht evolutionär in Richtung eines solchen Ansatzes transformieren, sondern als „Algorithmic Entities“ [15] bereits nativ („von Geburt an“) als solche angelegt sind.

Abbildung 1: Abdeckung KI im Unternehmen (Projizierung auf Prozesshaus)

Unternehmerische Verantwortung für den KI-Einsatz

Der Einsatz von KI in Unternehmen kann deren Fähigkeiten wie Entscheidungsgeschwindigkeit, Effizienz, Analyse (z. B. Märkte, Kunden, Technologie) aber auch Kreativität positiv beeinflussen und damit Wettbewerbsvorteile in vielen Bereichen (z. B. Innovation, Reputation oder Kostenstruktur) aufbauen. Zudem beeinflusst KI schon heute die Entwicklung neuer Geschäftsmodelle zahlreicher Branchen [16], [17].

Gleichzeitig ergeben sich rechtliche, ethische und unternehmerische Risiken (Beispiele) [18]:

- Mangelhafte Entscheidungen (z. B. durch implizite, für die KI aber unverständliche Ziele)

- Diskriminierung/Bias (z. B durch Trainingsdaten, die aus der Vergangenheit stammen oder nur Ausschnitte abbilden) [17a]

- Unklare Haftung und Rechenschaft (z. B. durch singulär unproblematisches – in Gemeinschaft aber risikobehaftetes Wirken) [17b] oder unklare Rechenschaft bei mit externen Anwendungen vernetzten KI-Systemen)

- Negativer Einfluss auf Unternehmenskultur, Mitarbeitermotivation und Integrität (z. B. durch angeordnetes Befolgen nicht nachvollziehbarer Entscheidungen)

- Entstehung einer neuen Art der Unternehmensführung als „Super-User“, mit „ultimativer“ Entscheidungsbefugnis – über alle KI-Entscheidungen

- Negativer Einfluss auf Menschen und Umwelt (z. B. durch KI-Entscheidungen mit direkter Auswirkung auf die berufliche, aber auch private und familiärere Situation von Mitarbeitern)

Die Regulierung von Risiken im Unternehmenskontext ist über staatliches Recht allein nicht sicher zu stellen, da multinationale Unternehmen, wie auch z. B. zur Steuervermeidung, in andere Länder ausweichen können und dazu möglicherweise sogar gegenüber ihren Shareholdern verpflichtet sind. KI-freundliche Gesetze in nationalen Rechtsordnungen können zu einem neuen Regulierungswettbewerb nach unten führen [19]. So könnten native KI-Unternehmen (AI-as-the-organitzation) die Arbitrage des regulatorisch optimierten Nomadisierens zum Teil des Geschäftsmodells werden lassen. Eine Regulierung auf nationaler Ebene oder auch im Staatenverbund wird daher zur Einhaltung ethischer Standards nicht genügen: Es ergibt sich die Forderung nach Übernahme unmittelbarer unternehmerischer Verantwortung für die Folgen digitalen Handelns.

Die Wahrnehmung einer freiwilligen, über das gesetzlich Vorgeschriebene hinausgehenden, unternehmerischen Verantwortung, für die Folgen der Entwicklung, Verbreitung oder Nutzung digitaler Technologien auf die Gesellschaft insgesamt aber auch die konkrete einzelne Person wird unter dem Begriff Corporate Digital Responsibility (CDR) diskutiert [20], [21], für die insbesondere Compliance und Integrität von Bedeutung sind und zusammen auf die Vermeidung rechtlichen und ethischen Fehlverhaltens fokussieren [9] (s. Abbildung 2)

Abbildung 2: Ausgestaltung einer wirksamen CDR (Anlehnung an [9], [22], [23])

CDR kodifiziert Vertrauen und schafft einen Handlungs- und Entscheidungsrahmen, der zeigt, wie KI-Risiken und -Chancen auszubalancieren sind, um der sozialen Verantwortung von Unternehmen hinsichtlich digitaler Fragestellungen gerecht zu werden. In einer wohldurchdachten CDR steckt das Potenzial zur Differenzierung und Schaffung von Wettbewerbsvorteilen durch Erlangung von Vertrauen der Stakeholder gegenüber dem Unternehmen.

Auswirkungen von KI in der Unternehmensführung

Unternehmensführung besteht aus Herbeiführen, Treffen und Umsetzen von Entscheidungen, durch die festgelegt wird, wie die Arbeit von Menschen im Unternehmen koordiniert und die Entwicklung des Unternehmens geprägt wird [24]. Die Unternehmensführung ist daher zweifellos diejenige Unternehmensfunktion, die den größten Einfluss auf das Unternehmen selbst (z. B. Positionierung, Erfolg, Prozesse, Mitarbeiter), seine Share- und Stakeholder (z. B. Eigentümer, Kunden, Lieferanten) und seine politische, rechtliche, gesellschaftliche, ökologische und technische Umwelt hat.

Entscheidungen der Unternehmensführung sind gekennzeichnet von hoher Unsicherheit, Volatilität, Komplexität und Wirkung. Aus diesem Blickwinkel betrachtet, bietet die Unternehmensführung ein vielversprechendes Einsatzgebiet für KI-Systeme.

„Die Wahrheit ist, dass das Geschäft zu komplex geworden ist und sich zu schnell bewegt, als dass Vorstände und CEOs ohne intelligente Systeme gute Entscheidungen treffen könnten“ [25].

Der KI-Einsatz in der Unternehmensführung lässt zahlreiche Auswirkungen erwarten:

1) Strategische KI-Entscheidungen haben massive, komplexe und unmittelbare Auswirkungen auf Menschen, die direkt (z. B. Mitarbeiter und Familien) oder indirekt (z. B. Zulieferer, Servicekräfte) betroffen sind.

2) Entscheidungen, von einer als objektiv, neutral und überlegen angesehenen KI-Entscheidungsarchitektur getroffen, haben starke Legitimationsfunktion für Management und Eigentümer. Ähnlich wie bisher vielleicht Unternehmensberatungen (mutmaßlich neutrale und objektive Instanz) als Sündenbock unangenehmer Entscheidungen herangezogen werden, wird KI diese Rolle mit noch mehr Gewicht ausfüllen.

3) Die Beziehung von Eigentümer und Management (Prinzipal-Agent) verändert sich: Während Manager bisher gerade wegen ihrer besonderen Fähigkeit, Entscheidungen auf Basis ihrer persönlichen Erfahrungen auch „aus dem Bauch heraus“ zu treffen, ausgesucht werden und die Nachvollziehbarkeit von Management-Entscheidungen für Eigentümer nicht immer gegeben ist, können Eigentümer und Dritte (z. B. interner/externer Audit, Insolvenzverwalter) nun sehr einfach verfolgen, bei welchen Entscheidungen sich das Management nicht an KI-Empfehlungen hielt. Bei einer Abweichung wird das Management seine Entscheidungen deutlich stärker als bisher erklären müssen. KI-Entscheidungen nicht oder anders umzusetzen, führt möglicherweise zu rechtlichen Konsequenzen: So gilt in Deutschland seit 1997 die sog. Business Judgement Rule (§ 93 Abs. 1 Satz 2 AktG), die besagt, dass Vorstände nur dann nicht für negative Folgen unternehmerischer Entscheidungen haften, wenn die Entscheidung u. a. auf Grundlage angemessener Informationen getroffen wurde. Vorstände müssen dies im Zweifel beweisen (§ 93 Abs. 2 Satz 2 AktG). Können Sie dies nicht (z. B. im Falle einer nicht absolut nachvollziehbar begründeten Abweichung von der KI-Entscheidung), sind sie dem Unternehmen zum Ersatz des entstandenen Schadens aus ihrem Privatvermögen verpflichtet.

4) Diese neuartige Beziehung zwischen Eigentümern und Management sowie das zumindest teilweise intransparente Zustandekommen von Entscheidungen, wandelt Führungspraktiken, Rolle und Kompetenzanforderung des Top-Managements vom modernen, partizipativen, risikonehmenden Unternehmensführer und Entscheider zum reinstitutionalisiert-autoritären, risikoaversen Umsetzer und Controlle

5) Das Gefühl von Maschinen regiert zu werden, wirkt sich auf Unternehmenskultur, Mitarbeitermotivation und Integrität aus: Während in der Ära der Mechanisierung, Maschinen einfache, repetitive Arbeiten für Menschen ausführen, und in der Zeit der Automatisierung Maschinen einfache Arbeiten selbstständig erledigen, führen nun Menschen Arbeiten für Maschinen aus. In KI geprägten Unternehmen wird insgesamt ein Ungleichgewicht zugunsten von Compliance und zulasten von Integrität entstehen.

6) Weiterhin sind viele weitere wichtige Risiken (etwa Diskriminierung oder Haftungsfragen) zu berücksichtigen.

In einer zukünftigen Entwicklungsstufe ist für bestimmte Bereichen denkbar, die gesamte Strategische Planung (von Analyse bis Controlling) in autonome KI-Systeme zu überführen (s. o. AI-covers-the‑organization). Ein Eingreifen des Managements in die Entscheidungen ist nur noch im Ausnahmefall vorgesehen („Human-in-Command“), denn „Human-in-the-Loop-Ansätze in der Unternehmensführung erscheinen wenig sinnvoll, wenn es zu Effizienzgewinnen kommen soll [8]. Nur die Umsetzung wird noch in den Händen von Menschen liegen, die aber eher die Rolle dezentraler Projektleiter haben, als Managementfunktion in der Linie. Dennoch bleibt nach heutiger Rechtsordnung die Rechenschaftspflicht vorerst bei der (menschlichen) Unternehmensleitung, selbst wenn der gesamte Entscheidungsfindungsprozess automatisiert wäre [7].

Fazit

Grundsätzlich kann der Einsatz von KI in der Unternehmensführung positive Auswirkungen haben. Probleme entstehen vor allem dadurch, dass sich der Mensch potenziell immer weiter von Entscheidungsprozessen entfernt und Unternehmen KI-Systeme heranziehen, um Entscheidungen, die die Interessen der Shareholder über die Interessen der Allgemeinheit stellen zu legitimieren.

Die verantwortlichen Personen in Unternehmen sind gefordert, auf Basis ihrer eigenen spezifischen Situation, kontinuierlich rechtliche und ethische Fragestellungen zu reflektieren und entsprechende Fähigkeiten zu entwickeln. Dabei kann das Instrument der „Corporate Digital Responsibility“ (CDR) einen Rahmen für die Entwicklung eigener Verantwortungskomponenten bieten. Die zentrale Herausforderung liegt dabei in der Ausbildung und Verankerung von Integrität über die gesamte Kette: vom Design des KI-Systems, über Entwicklung, Verbreitung, Implementierung, Anwendung und Betrieb bis zur Pflege.

Integrität lässt sich nicht programmieren.

Fußnoten

[1] DFKI und bitkom, „Künstliche Intelligenz. Wirtschaftliche Bedeutung, gesellschaftliche Herausforderungen, menschliche Verantwortung,“ 2017. [Online]. Available: https://www.dfki.de/fileadmin/user_upload/import/9744_171012-KI-Gipfelpapier-online.pdf.

[2] P. Drucker, „The manager and the moron,“ McKinsey Quarterly, 3(4), 1967.

[3] H. Schlinger, „The Myth of Intelligence,“ he Psychological Record, Vol. 53, No. 1, 2003.

[4] A. Kaplan und M. Haenlein, „Rulers of the World, Unite! The Challenges and Opportunities of Artificial Intelligence,“ Business Horizons, Vol. 63, No. 1, 2020.

[5] R. Sternberg, „The Theory of Successful Intelligence,“ Interamerican Journal of Psychology, Vol. 39, No. 2, 2005.

[6] Hochrangige Expertengruppe für KI, „Ethik-Leitlinien für eine vertrauenswürdige KI,“ Europäische Kommission, Brüssel, 2018.

[7] M. Hilb, „Toward artificial governance? The role of artificial intelligence in shaping the future of corporate governance,“ Journal of Management and Governance 24, 2020.

[8] E. P. M. Hickman, „Trustworthy AI and Corporate Governance: The EU’s Ethics Guidelines for Trustworthy Artificial Intelligence from a Company Law Perspective,“ European Business Organization Law Review, 2021.

[9] C. Schank, „Algorithmen und ihr Einfluss auf Compliance und Integrity,“ Bertelsmann Stiftung: Unternehmensverantwortung im digitalen Wandel, 2020.

[10] K. Elliott, R. Price, P. Shaw, T. Spiliotopoulos, M. Ng, K. Coopamooto und A. Moorsel, „Towards an Equitable Digital Society: Artificial Intelligence (AI) and Corporate Digital Responsibility (CDR),“ Society 58, 2021.

[11] F. Daumann-Habersack, „Autorität, Algorithmen und Konflikte – Die digitalisierte Renaissance autoritärer Führungsprinzipien,“ in Kooperation in der digitalen Arbeitswelt. Verlässliche Führung in Zeiten virtueller Kommunikation, O. Geramanis, S. Hutmacher und L. Walser, Hrsg., 2021.

[12] F. Pasquale, „The black box society: The secret algorithms that control money and information,“ Harvard University Press, 2015.

[13] D. Elton, Self-explaining AI as an Alternative to Interpretable AI, 2020.

[14] S. Lapuschkin, S. Wäldchen und A. e. a. Binder, „Unmasking Clever Hans predictors and assessing what machines really learn,“ Nature Communications volume 10, 2019.

[15] L. LoPucki, „Algorithmic entities,“ Wash Univ Law Rev 95, 2018.

[16] C. Dukino, M. Friedrich und e. al, „Künstliche Intelligenz in der Unternehmenspraxis,“ W. Bauer, W. Ganz, M. Hämmerle und T. Renner, Hrsg., 2019.

[17] A. Huber, „Geschäftsmodellinnovation in disruptiven Branchen. Am Beispiel der Berufsfotografie,“ Wirtschaftsinformatik & Management (13), 2021.

[17a] Beispiele: (1) Medikamente wirken und Spracherkennung funktioniert bei Männern besser als bei Frauen. Grund: zu wenig Trainingsdaten von Frauen (2) Männer werden eher für Führungspositionen ausgewählt. Grund: weniger Frauen auf Führungspositionen in der Vergangenheit (3) Gesichtserkennung arbeitet bei weißen Menschen besser als bei schwarzen. Grund: zu wenig Trainingsdaten von schwarzen Menschen.

[17b] Beispielsweise könnten Auftraggeber, Entwickler, Händler und Nutzer von Algorithmen und Trainingsdaten jeweils plausibel erklären, dass ihr Zutun allein unkritisch ist. Nur in Summe entsteht das Risiko. Ebenso ist die Problematik einer Anbindung externer KI-Systeme mit unzureichender XAI zu sehen.

[18] T. Simonite, „Tech firms move to put ethical guard rails around AI,“ WIRED, 2018.

[19] Eidenmüller, „The rise of robots and the law of humans,“ Oxford Legal Studies Research Paper No 27/201, 2017.

[20] DEK, „Gutachten der Datenethikkommission,“ Datenethikkommission der Bundesregierung, Berlin, 2019.

[21] M. Schmidt, Ethik in der IT-Sicherheit, Berlin, 2021.

[22] E. Göbel, Unternehmensethik, Konstanz und München, 2016.

[23] B. Noll, Wirtschafts- und Unternehmensethik in der Marktwirtschaft, Stuttgart, 2002.

[24] E. Heinen, „Der entscheidungsorientierte Ansatz der Betriebswirtschaftslehre,“ Zeitschrift für Betriebswirtschaft, 41. Jg., 1971.

[25] B. Libert, M. Beck und M. Bonchek, „https://sloanreview.mit.edu,“ 2017. [Online].

Prof. Dr. Alexander Huber

Prof. Dr. Alexander Huber

lehrt an der Berliner Hochschule für Technik. Zuvor war er zehn Jahre im Führungskreis von Siemens und Berater bei Accenture. Als in Informatik promovierter Wirtschaftsingenieur forscht er an der Schnittstelle von Strategie, Organisation und IT.

E-Mail: a.huber@bht-berlin.de

Website