UPRAVLJANJE UČENJA

19 Težave s podatki: pristranskost in poštenost

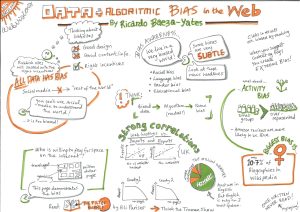

Pristranskost pomeni imeti predsodke v odnosu do določene identitete, v pozitivnem ali negativnem smislu, namerno ali nenamerno1. Poštenost je nasprotje pristranskosti in se nanaša na pravično obravnavo vseh ljudi, ne glede na njihovo identiteto ali položaj. Zato je treba vzpostaviti in slediti jasno določenim postopkom, če želimo zagotoviti, da bodo vsi obravnavani enako in da bodo imeli enake možnosti1.

Sistemi, ki jih je zasnoval človek, pogosto vsebujejo veliko mero pristranskosti in diskriminacije. Vsi ljudje imamo svoja mnenja in tudi predsodke. Lahko bi rekli, da smo tudi ljudje (in s tem seveda učitelji) “črne skrinjice”, katerih odločitve je včasih težko razumeti (na primer, kako je nekdo točkoval rešitve šolskega testa). Toda razvili smo tudi strategije in vzpostavili strukture, ki nam pomagajo, da smo pozorni na takšne prakse in o njih kritično razpravljamo.

Avtomatizirane sisteme včasih dojemamo kot čudežno zdravilo za človeško subjektivnost: algoritmi temeljijo na številkah, le kako bi lahko bili pristranski? Toda algoritmi, ki temeljijo na napačnih podatkih, ne le zaznajo in se naučijo obstoječih predsodkov v zvezi s spolom, raso, kulturo ali invalidnostjo, temveč jih lahko dejansko okrepijo1,2,3. In tudi če govorimo o sistemih, zaščitenih z lastništvom, od njih ne moremo pričakovati, da bodo odgovarjali za svoja dejanja (odločitve), zaradi inherentnega pomanjkanja razložljivosti v nekaterih sistemih (npr. sistemih, ki temeljijo na globokih nevronskih mrežah).

Primeri pristranskosti v sistemih AIED

- Ko programerji kodirajo sisteme, ki temeljijo na pravilih, lahko v sistem vnesejo svoje osebne predsodke in stereotipe1.

- Na podatkih temelječ algoritem se lahko odloči, da dekletom ne predlaga poklicne poti na področju STEM, ker sklop podatkov o diplomantih STEM vsebuje manj deklet kot fantov. Ali je manjše število žensk v matematiki posledica obstoječih stereotipov in družbenih norm, ali pa je to posledica neke prirojene lastnosti ženskega spola? Algoritmi ne razlikujejo med temi značilnostmi. Ker obstoječi podatki odražajo obstoječe stereotipe, algoritmi, ki se na njih učijo, posnemajo obstoječe neenakosti in družbeno dinamiko4. In če bodo priporočila takšnega sistema upoštevana, se bo še več deklet odločilo za predmete zunaj področja STEM, in novi podatki bodo kasneje to spet odražali – to je primer samouresničujoče se prerokbe3.

- Učenci iz kulturnih okolij, ki so premalo zastopana v sklopu učnih podatkov, imajo lahko drugačne vedenjske vzorce in drugačne načine izkazovanja motivacije. Kako bi učna analitika izračunala vrednosti zanje? Če podatki niso reprezentativni za vse kategorije učencev, lahko sistemi, ki so se učili na teh podatkih, kaznujejo manjšine z vedenjskimi težnjami drugačnimi od tistih, za katere je bil program optimiziran, da jih nagradi. Če ne bomo previdni, bodo učni algoritmi začeli posploševati na podlagi večinske kulture, kar bo povzročilo visoko stopnjo napak za manjšinske skupine4,5. Takšne odločitve bodo nemara odvrnile tiste, ki bi sicer v skupino lahko vnesli raznolikost, ustvarjalnost ali izjemne talente, pa tudi tiste z drugačnimi izkušnjami, interesi in motivacijo2.

- Britanski učenec, čigar pisni sestavek oceni ameriška programska oprema za popravljanje esejev, je lahko kaznovan zaradi napak v črkovanju. Za sisteme, ki so zasnovani in usposobljeni za delovanje v točno določeni državi ali kontekstu, so lokalne različice jezika, razlike v črkovanju in naglaševanju besed ter lokalna geografija in kultura vedno problematični.

- Nekateri učitelji kaznujejo izraze, ki so običajni v določeni skupini ali regiji, pa naj to počnejo zavestno, ali zaradi nezavednih asociacij, ki vsebujejo predsodke. Če se programska oprema za ocenjevanje esejev uči na esejih, ki so jih ocenili takšni učitelji, potem bodo isti predsodki vsebovani tudi v njej.

- Sistemi strojnega učenja potrebujejo ciljno spremenljivko in približke, h katerim stremijo z optimizacijo. Recimo, da so bili rezultati srednješolskih testov vzeti kot približek akademske odličnosti. Sistem se bo zdaj učil spodbujati izključno vzorce, skladne z učenci, ki se dobro znajdejo pod stresom, oz. v specifičnih okoliščinah reševanja testov. Ko bodo učencem priporočali vire in praktične vaje, bodo takšni sistemi promovirali rezultate testov in ne splošnega znanja. Čeprav se to dogaja tudi v številnih današnjih učilnicah, pa je tradicionalni pristop vsaj omogočal izražanje več različnih ciljev4.

- Prilagodljivi učni sistemi učencem predlagajo vire za odpravo pomanjkanja veščin ali znanja. Če je treba te vire kupiti ali zahtevajo domačo internetno povezavo, potem to ni pošteno do tistih učencev, ki nimajo sredstev za upoštevanje priporočil. “Kadar algoritem učencem predlaga namige, naslednje korake ali vire, moramo preveriti, ali je takšna pomoč pravična. Če določena skupina sistematično ne dobiva pomoči, je takšno ravnanje diskriminatorno“2.

- Ideja o personaliziranem izobraževanju glede na učenčevo trenutno raven znanja in preference nemara že sama po sebi vsebuje predsodek1. Ali s tem učenca hkrati ne oviramo pri raziskovanju novih interesov in alternativ? Ali to učenca pravzaprav ne zreducira na enodimenzionalnost in s tem okrni njegove splošne veščine, znanje in pravico do enakih možnosti?

Kaj lahko učitelj stori, da zmanjša učinke pristranskosti AIED?

Raziskovalci nenehno predlagajo in analizirajo različne načine za zmanjšanje pristranskosti. Vendar pa vseh metod ni enostavno uvesti v praksi: poštenost je veliko več kot le zmanjšanje pristranskosti.

Na primer, če obstoječi podatki vsebujejo veliko stereotipov, “ali nas obvezuje odgovornost, da dvomimo o podatkih in oblikujemo naše sisteme tako, da bodo v skladu z neko idejo pravičnosti, ne glede na to, ali podatki, ki so nam trenutno na voljo, to podpirajo ali ne?“4. Metode so vedno konkurenčne in v nasprotju druga z drugo; ukrepi za zmanjšanje ene vrste pristranskosti lahko povzročijo druge vrste pristranskost!

Kaj lahko torej stori učitelj?

- Preverite prodajalca: preden se odločite za naročnino za določen sistem AIED, se vprašajte, na kakšnih podatkih se je sistem učil, kje in kdo je ta sistem zasnoval in za koga ter kako je bil sistem ocenjen.

- Ne zaupajte na prvi pogled. Na primer, ocena splošne zanesljivosti z do 5-odstotno napako lahko prikrije dejstvo, da je model slabo učinkovit za določeno manjšinsko skupino4.

- Podrobno preberite dokumentacijo: katere ukrepe izvaja sistem za odkrivanje in preprečevanje pristranskosti ter zagotavljanje poštenosti1?

- Pridobite informacije o razvijalcih: ali so sistem razvili izključno programerji, ali pa so bili v proces vključeni tudi izobraževalni delavci in raziskovalci? Ali sistem temelji izključno na strojnem učenju, ali pa so vanj vključene tudi učne teorije in prakse2?

- Dajte prednost transparentnim, odprtim modelom učenja, ki vam omogočajo, da preglasite njihove odločitve2: veliko modelov AIED ima prilagodljivo zasnovo, ki omogoča, da učitelji ali učenci spremljajo, zahtevajo razlago, ali popolnoma prezrejo odločitev sistema.

- Prepričajte se o dostopnosti: ali je sistem dostopen vsem na enak način, ne glede na njihove zmožnosti1?

- Bodite pozorni na učinke uporabe tehnologije na učence, tako dolgoročne kot kratkoročne, in bodite pripravljeni ponuditi pomoč, ko je to potrebno.

Kljub izzivom, ki jih prinašajo na UI utemeljene tehnologije, smo lahko optimistični glede prihodnosti AIED:

- Z večjo ozaveščenostjo o tej tematiki se raziskuje in preizkuša vse več metod za odkrivanje in zmanjševanje pristranskosti.

- Na pravilih in na podatkih temelječi sistemi lahko pomagajo razkriti skrite predsodke v obstoječih izobraževalnih praksah, kar omogoča njihovo obravnavo.

- Potencial po meri zasnovanih sistemov UI bi lahko v prihodnje omogočil prilagoditve številnih vidikov izobraževanja. Viri bi lahko postali prilagojeni znanju in izkušnjam vsakega učenca. Lahko bi se opirali na lokalne skupnosti in kulturne dobrine ter zadovoljili specifične lokalne potrebe2.

1 Ethical guidelines on the use of artificial intelligence and data in teaching and learning for educators, European Commission, October 2022.

2 U.S. Department of Education, Office of Educational Technology, Artificial Intelligence and Future of Teaching and Learning: Insights and Recommendations, Washington, DC, 2023.

3 Kelleher, J.D, Tierney, B, Data Science, MIT Press, London, 2018.

4 Barocas, S., Hardt, M., Narayanan, A., Fairness and machine learning Limitations and Opportunities, 2022.

5 Milano, S., Taddeo, M., Floridi, L., Recommender systems and their ethical challenges, AI & Soc 35, 957–967, 2020.