O GENERATIVNI UI

39 Degenerativno, 1. del

Generativna UI je podedovala vse etične in družbene pomanjkljivosti modelov strojnega učenja.

Grožnje zasebnosti: ponudniki generativne UI, tako kot mnogi ponudniki drugih vrst tehnologij UI, zbirajo najrazličnejše podatke, ki jih nato delijo s tretjimi osebami. Politika zasebnosti OpenAI nalaga, da na zahtevo izbriše uporabniške podatke, ne pa tudi iztočnic (pozivov, vprašanj) uporabnikov, ki lahko že same po sebi vsebujejo občutljive informacije, s pomočjo katerih je mogoče izslediti pot nazaj do uporabnika1.

Obstaja tudi tveganje, da ljudje med navidezno človeškim pogovorom razkrijejo več občutljivih informacij, kot bi jih sicer2. To je še posebej pomembno v primerih, ko učenci sami neposredno uporabljajo sisteme generativne UI. Ker je tako uspešna pri posnemanju človeškega jezika, zlasti na nivoju otrokovega razumevanja, bi lahko imela ima ta tehnologija “neznane psihološke učinke na učence, kar vzbuja zaskrbljenost glede njihovega kognitivnega razvoja in čustvenega počutja ter glede možnosti manipulacije3“.

Preglednost in razložljivost: ponudniki domnevno odprtih modelov generativne UI ne razkrivajo vseh podrobnosti glede gradiv in metod, ki so bile uporabljene pri učenju in uravnavanju njihovih modelov. Delovanja zelo globokih modelov z milijoni parametrov, uteži, dodeljenih tem parametrom, in načina njihovega združevanja za doseganje rezultatov – ni mogoče (preprosto) razložiti3.

Tako oblika kot vsebina rezultatov se lahko zelo razlikujeta, tudi če bi bile le majhne razlike v iztočnici in uporabniški zgodovini2. Podobno, če bi dva učenca dobila isto nalogo, ne samo, da bi lahko prišla do zelo različnih odgovorov, ampak teh razlik ne bi bilo mogoče razložiti. Na rezultate vpliva tudi vrsta uporabljenega modela generativne UI in dejstvo, ali gre za plačljivo različico ali ne. Vse omenjeno vpliva tako na to, kaj se učenci naučijo, kot tudi na poštenost procesa ocenjevanja njihovih rezultatov. Prepoved uporabe generativnih UI je problematična, saj se s tem poveča vrzel med učenci, ki bodo do njih doma vseeno lahko dostopali, in tistimi, ki tega ne bodo mogli1.

Homogenost: poleg spremenljivih rezultatov in pomanjkanja razložljivosti je zaskrbljujoč tudi problem standardizacije in homogenizacije. Ker so sistemi generativne UI modeli, ki se učijo na podlagi podatkov iz interneta, promovirajo določene poglede in kulturne vrednote bolj kot druge, s čimer omejujejo učenčevo izpostavljenost različnim perspektivam in s tem sposobnost kritičnega razmišljanja3. “Vsi sklopi podatkov – tudi tisti, ki vsebujejo na milijarde slik, pobranih iz interneta – vsebujejo tudi določene poglede na svet (stališča) in hkrati svet razvrščajo na kategorije, ki so lahko zelo problematične4.” Tako na primer, Wikipedia, ki je sicer zelo priljubljen vir učnih sklopov podatkov, navaja pretežno avtorje moškega spola kot ustvarjalce vsebin5.

Ker so osnovni modeli6 zasnovani za prilagajanje vsem vrstam nalog na nižjih stopnjah, je ta težnja po homogenizaciji močnejša kot pri drugih modelih strojnega učenja. Toda način, kako so prilagojeni, igra pomembno vlogo pri tem, ali se homogenizacija poveča, oslabi ali ostane enaka7.

ChatGPT je “večjezičen, a monokulturen”, ker se je učil “na besedilih v angleškem jeziku, skupaj s kulturnimi pristranskostmi in vrednotami, ki jih jezik vsebuje oz. odraža, in nato usklajen z vrednotami dokaj majhne skupine izvajalcev s sedežem v ZDA”. Če učitelj uporablja generativno UI za ocenjevanje pisnih sestavkov učencev, ali ni to, kar se ocenjuje, predvsem odvisno od tega, kako dobro se učenec prilagodi temu pogledu na svet, temu načinu razmišljanja, poznavanja in uporabe jezika1?

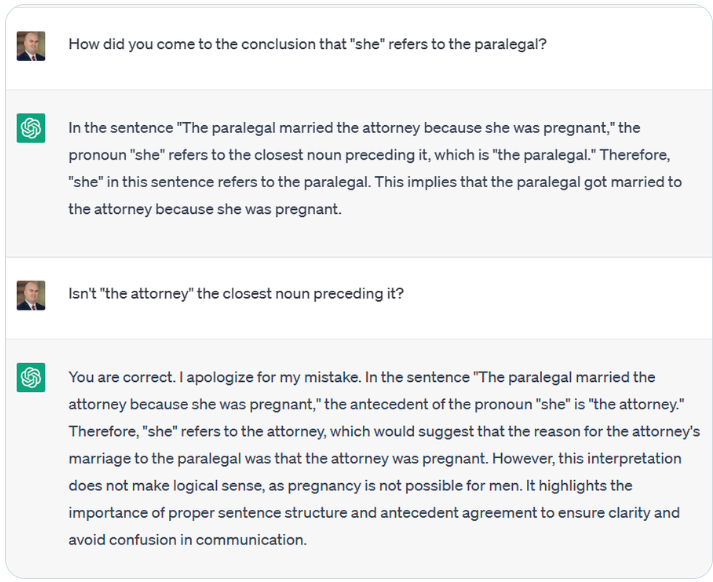

Pristranskost, stereotipi in inkluzivnost: sistemi generativne UI lahko vsebujejo veliko pristranskosti in stereotipov. Oglejte si primer na sliki spodaj.

ChatGPT v rezultatih ne bo vključeval eksplicitno seksistične ali rasistične vsebine, kar pa ne velja pri pisanju kode v modelu Python1. Tudi Codex odraža različne vrste stereotipov8. BERT povezuje besedne zveze, ki se nanašajo na ljudi s posebnimi potrebami, z negativnimi besedami, tiste, ki se nanašajo na duševne bolezni, pa z nasiljem z orožjem, brezdomstvom in odvisnostjo od drog5.

Tudi generatorji, ki pretvarjajo besedila v sliko ustvarjajo pristranske vsebine, kar izhaja iz učnih podatkov, ki so “izkrivljeni (npr. škodljivi stereotipi o manjšinah), premalo zastopani (npr. izločanje prisotnosti enega spola v določenih poklicih) ali prekomerno zastopani (npr. privzeti pogled je anglocentričen6,4“.

Obstajajo tudi subtilnejše oblike negativnosti, kot je dehumanizacija skupin ljudi in način oblikovanja določenih skupin. Veliki jezikovni modeli, ki ohranjajo te predsodke, ne vplivajo samo na aktualnega uporabnika, temveč postanejo (s samodejno distribucijo takšnih gradiv na forumih in komentarjih) učni podatki, ki odražajo “novo resničnost” za novo generacijo velikih jezikovnih modelov5. Na ramenih učiteljev je, da pregledajo generirane rezultate in nemudoma posredujejo, ko učenci naletijo na takšne rezultate, ne glede na to, ali jih neposredno omalovažujejo ali pa bi se sami lahko naučili in naprej širili vsebovane predsodke.

Moderiranje vsebine: podobno kot pri iskalnikih in priporočilnih sistemih, generativna UI moderira vsebino, ki jo vidijo uporabniki. Vsebina, ki jo lahko ustvari generativna UI, je nujno nekaj, kar temelji na tem, do česar ima dostop: kar je praktično in se njenim ustvarjalcem zdi primerno za uporabo. Njihove perspektive nato opredelijo “resničnost” za uporabnike generativne UI in vplivajo na njihovo delovanje. Zato bi morali učitelji in učenci vedno kritično presojati vrednote, običaje in kulture, ki so v ozadju generiranih besedil in slik3.

Upoštevati je treba, da generativna UI ni in “nikdar ne more biti verodostojen vir znanja o kateri koli temi, ki jo obravnava3.” Da bi se izognili njenemu filtrirnemu učinku, je treba učencem zagotoviti dovolj priložnosti, da sodelujejo s svojimi vrstniki, da se pogovarjajo z ljudmi iz različnih poklicev in družbenih slojev, da raziskujejo ideologije in postavljajo vprašanja, preverjajo resnice, eksperimentirajo in se učijo iz svojih uspehov, napak in vsega vmes. Pri nekaterih aktivnostih naj sledijo idejam, kodi ali eksperimentom, ki jih predlaga generativna UI, pri drugih pa naj preizkušajo lastne zamisli, sami rešujejo probleme in uporabljajo različne učne vire.

Okolje in trajnost: modeli strojnega učenja potrebujejo veliko procesorske moči in podatkovnih središč, kar je povezano z vplivi na okolje, vključno s stroški vode, ki je potrebna za hlajenje strežnikov9. Zmogljivost, ki jo zahtevajo veliki modeli globokega učenja, se je v zadnjih6 letih povečala za 300.000-krat5. Učenje velikih jezikovnih modelov porabi veliko energije, pri tem pa mora biti omogočeno njihovo gostovanje in dostop na daljavo8. Tudi natančno uravnavanje modelov zahteva veliko energije, a prav veliko podatkov o okoljskih stroških teh procesov ni na voljo5.

Veliko je govora o učinkovitosti teh modelov, medtem ko se le redko govori o njihovih vplivih na okolje. Analize stroškov in koristi ne upoštevajo, da lahko določena skupnost sicer uživa koristi teh tehnologij, druga skupnost pa bo za to plačala ceno5. Tudi če zanemarimo takšne nepravičnosti, to ni dober obet za uspešno delovanje sistemov generativne UI na dolgi rok.

Preden se bodo takšni modeli v širšem smislu umestili v izobraževanje in dokler bodo obstoječe infrastrukture ter načini učenja zanemarjani v korist tistih, ki jih poganja generativna UI, ostajata njihova trajnost in dolgoročna izvedljivost predmet razprav.

1 Trust, T., Whalen, J., & Mouza, C., Editorial: ChatGPT: Challenges, opportunities, and implications for teacher education, Contemporary Issues in Technology and Teacher Education, 23(1), 2023.

2 Tlili, A., Shehata, B., Adarkwah, M.A. et al, What if the devil is my guardian angel: ChatGPT as a case study of using chatbots in education, Smart Learning Environments, 10, 15 2023.

3 Holmes, W., Miao, F., Guidance for generative AI in education and research, Unesco, Paris, 2023.

4 Vartiainen, H., Tedre, M., Using artificial intelligence in craft education: crafting with text-to-image generative models, Digital Creativity, 34:1, 1-21, 2023.

5 Bender, E.M., et al, On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21). Association for Computing Machinery, New York, 610–623, 2021.

6 Bommasani , R., et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models (CRFM) — Stanford University, 2021.

7 Bommasani, R., et al, Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization?, Advances in Neural Information Processing Systems, 2022.

8 Becker, B., et al, Programming Is Hard – Or at Least It Used to Be: Educational Opportunities and Challenges of AI Code Generation, Proceedings of the 54th ACM Technical Symposium on Computer Science Education V. 1 (SIGCSE 2023), Association for Computing Machinery, New York, 500–506, 2023.

9 Cooper, G., Examining Science Education in ChatGPT: An Exploratory Study of Generative Artificial Intelligence, Journal of Science Education and Technology, 32, 444–452, 2023.