Lernen managen

17 KI Sprache: Datenbasierte Systeme — Teil 2

Die Konzeption und Umsetzung eines datenzentrierten Projekts lässt sich in sechs Schritte unterteilen. Zwischen den einzelnen Schritten gibt es ein ständiges Wechselspiel, und der gesamte Prozess muss unter Umständen mehrmals wiederholt werden, bis er richtig funktioniert.

Um im Unterricht effektiv zu sein, sollten multidisziplinäre Teams mit Lehrkräften, pädagogischen Fachleuten und auf dem Gebiet der Informatik Tätigen an jedem Schritt des Prozesses beteiligt sein1. Menschliche Fachleute werden benötigt, um den Bedarf zu ermitteln und den Prozess zu entwerfen, die Daten zu sammeln und aufzubereiten, ML-Algorithmen auszuwählen, die Ergebnisse kritisch zu interpretieren und zu planen, wie die Anwendung genutzt werden soll2.

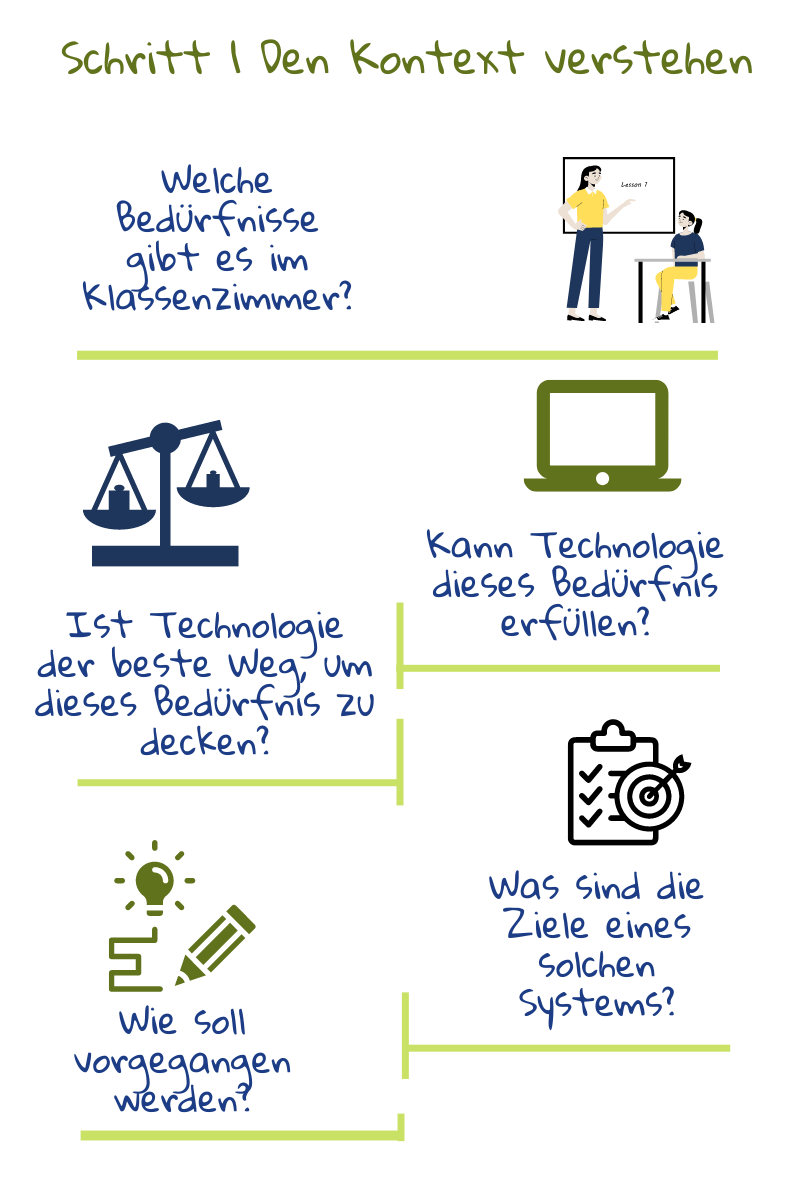

1) Verstehen des Bildungskontextes

Der erste Schritt bei der Entwicklung eines KI-Tools für die Bildung besteht darin, die Bedürfnisse im Klassenzimmer zu verstehen. Sobald die Ziele festgelegt sind, muss man analysieren, wie sie erreicht werden können: Welche Faktoren sind zu berücksichtigen und welche zu ignorieren? Jede datenbasierte Lösung ist auf Phänomene ausgerichtet, die sich leicht berechnen und standardisieren lassen3. Aus diesem Grund muss jede Entscheidung zwischen den Lehrkräften, die das Werkzeug verwenden werden, den Pädagogen, die sicherstellen können, dass alle Entscheidungen auf einer erprobten Theorie basieren, und den Informatikern, die die Funktionsweise der Algorithmen verstehen, diskutiert werden.

Der erste Schritt bei der Entwicklung eines KI-Tools für die Bildung besteht darin, die Bedürfnisse im Klassenzimmer zu verstehen. Sobald die Ziele festgelegt sind, muss man analysieren, wie sie erreicht werden können: Welche Faktoren sind zu berücksichtigen und welche zu ignorieren? Jede datenbasierte Lösung ist auf Phänomene ausgerichtet, die sich leicht berechnen und standardisieren lassen3. Aus diesem Grund muss jede Entscheidung zwischen den Lehrkräften, die das Werkzeug verwenden werden, den Pädagogen, die sicherstellen können, dass alle Entscheidungen auf einer erprobten Theorie basieren, und den Informatikern, die die Funktionsweise der Algorithmen verstehen, diskutiert werden.

Zwischen den beiden ersten Schritten gibt es ein ständiges Wechselspiel, denn was möglich ist, hängt auch davon ab, welche Daten zur Verfügung stehen2. Darüber hinaus unterliegt die Entwicklung von pädagogischen Hilfsmitteln auch Gesetzen, die die Nutzung von Daten und die Art der Algorithmen, die verwendet werden dürfen, einschränken.

2) Verstehen der Daten

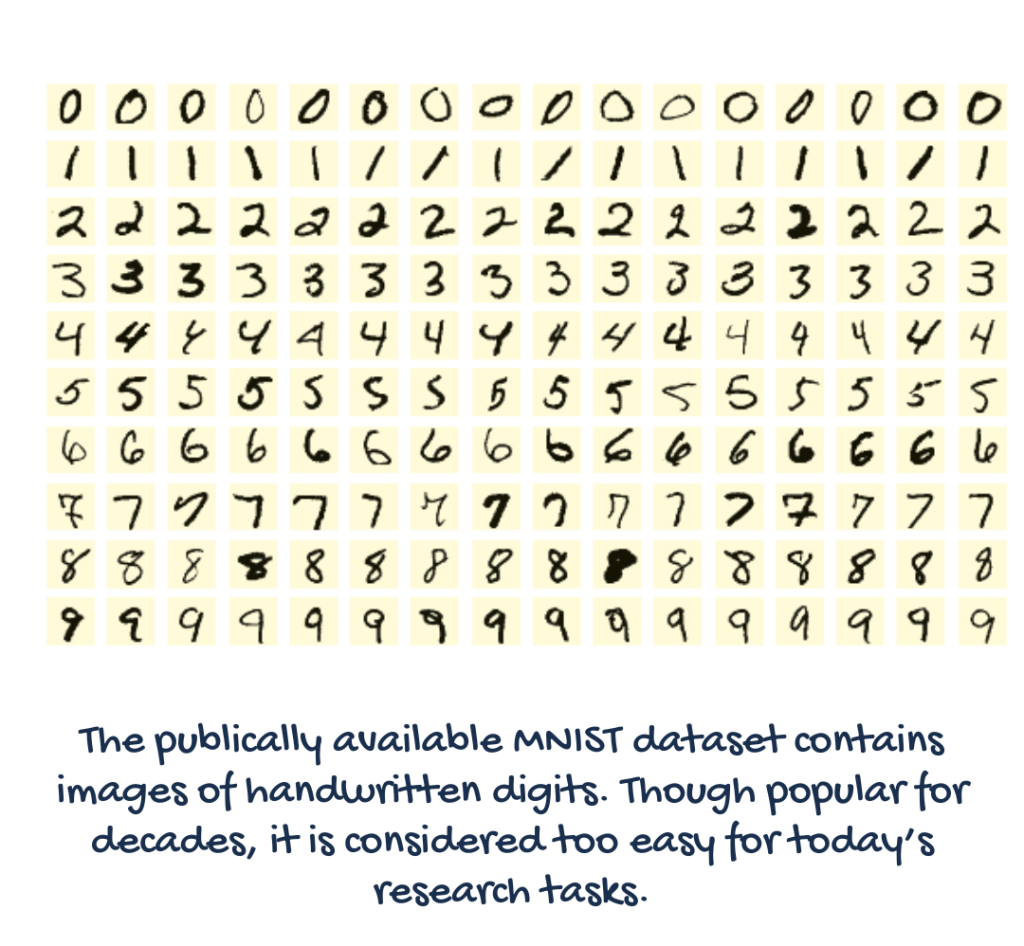

Sobald die Ziele und die dazu beitragenden Faktoren identifiziert sind, verlagert sich der Schwerpunkt darauf, welche Daten benötigt werden, wie sie beschafft und gekennzeichnet werden, wie der Datenschutz gehandhabt und wie die Datenqualität gemessen wird3. Damit eine Anwendung für maschinelles Lernen erfolgreich ist, müssen die Datensätze groß genug, vielfältig und gut gekennzeichnet sein.

Maschinelles Lernen benötigt Daten, um das Modell zu trainieren, und Daten, mit denen es arbeiten oder Vorhersagen treffen kann. Für einige ML-Aufgaben, wie Gesichts- und Objekterkennung, stehen bereits zahlreiche private und öffentliche Datenbanken für das Training zur Verfügung.

Wenn diese Daten nicht bereits in brauchbarer Form vorhanden sind, müssen vorhandene Datensätze möglicherweise ergänzt oder umetikettiert werden, damit sie den Anforderungen des Projekts entsprechen. Andernfalls, müssen möglicherweise eigene Datensätze erstellt und neu beschriftet werden. Digitale Spuren, die von den Schülerinnen und Schülern während der Nutzung einer Anwendung erzeugt werden, könnten ebenfalls als eine der Datenquellen verwendet werden.

In jedem Fall müssen die für das Problem relevanten Daten und Merkmale sorgfältig identifiziert werden2. Irrelevante oder redundante Merkmale können einen Algorithmus dazu bringen, falsche Muster zu finden und die Leistung des Systems zu beeinträchtigen2. Da die Maschine nur in den ihr zur Verfügung gestellten Daten Muster finden kann, definiert die Auswahl des Datensatzes implizit auch das Problem4. Wenn viele Daten zur Verfügung stehen, muss eine Teilmenge mit Hilfe statistischer Techniken ausgewählt und die Daten überprüft werden, um Fehler und Verzerrungen zu vermeiden.

Ein Beispiel für schlechte Trainingsdaten ist folgende Geschichte aus den Anfängen der Computer Vision: Ein Modell wurde trainiert, um Bilder von russischen und amerikanischen Panzern unterscheiden zu können. Später stellte sich heraus, dass seine hohe Genauigkeit darauf zurückzuführen war, dass die russischen Panzer an einem bewölkten Tag und die amerikanischen an einem sonnigen Tag fotografiert worden waren4.

Daher muss der gewählte Datensatz auf seine Qualität hin überprüft werden, wobei zu berücksichtigen ist, warum er erstellt wurde, was er enthält, welche Verfahren für die Sammlung, Reinigung und Kennzeichnung, Verteilung und Pflege der Daten verwendet werden4. Zu den wichtigsten Fragen gehören: Sind die Datensätze für ihren beabsichtigten Zweck geeignet? Und: Enthalten die Datensätze versteckte Gefahren, die Modelle verzerrt oder diskriminierend machen können3?

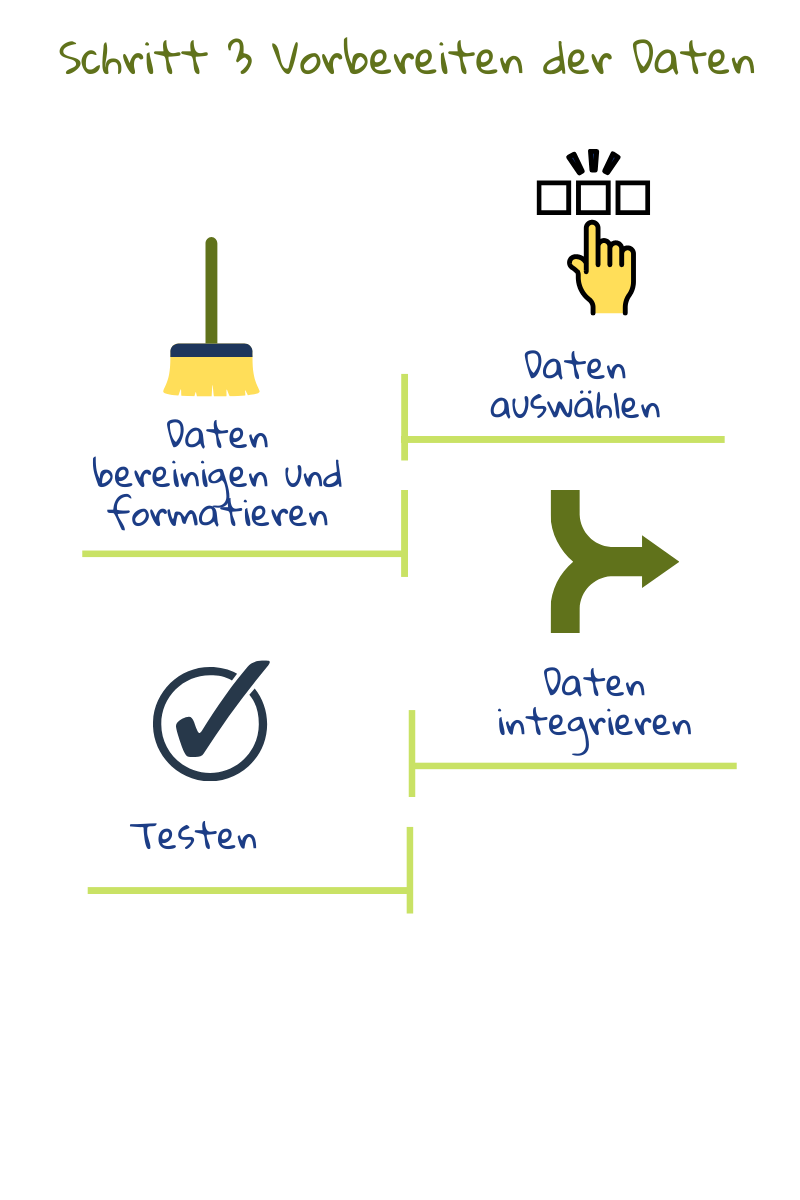

3) Aufbereitung der Daten

Zur Datenvorbereitung gehört die Erstellung von Datensätzen durch Zusammenführung von Daten aus verschiedenen Quellen, die Bereinigung von Inkonsistenzen (z. B. könnten einige Testergebnisse auf einer Skala von 1 bis 10 liegen, während andere als Prozentsatz angegeben werden) und die Suche nach fehlenden oder extremen Werten. Anschließend könnten automatisierte Tests durchgeführt werden, um die Qualität der Datensätze zu überprüfen. Dazu gehört auch die Überprüfung auf Datenschutzlücken und unvorhergesehene Korrelationen oder Stereotypen2. Die Datensätze könnten in dieser Phase auch in Trainings- und Testdatensätze aufgeteilt werden. Erstere werden zum Trainieren des Modells verwendet, letztere zum Überprüfen seiner Leistung. Das Testen des Trainingsdatensatzes wäre so, als würden Sie die Prüfungsaufgaben am Vortag als Hausaufgaben verteilen: Die Prüfungsleistung der Schülerinnen und Schüler sagt nichts über ihr Verständnis aus2.

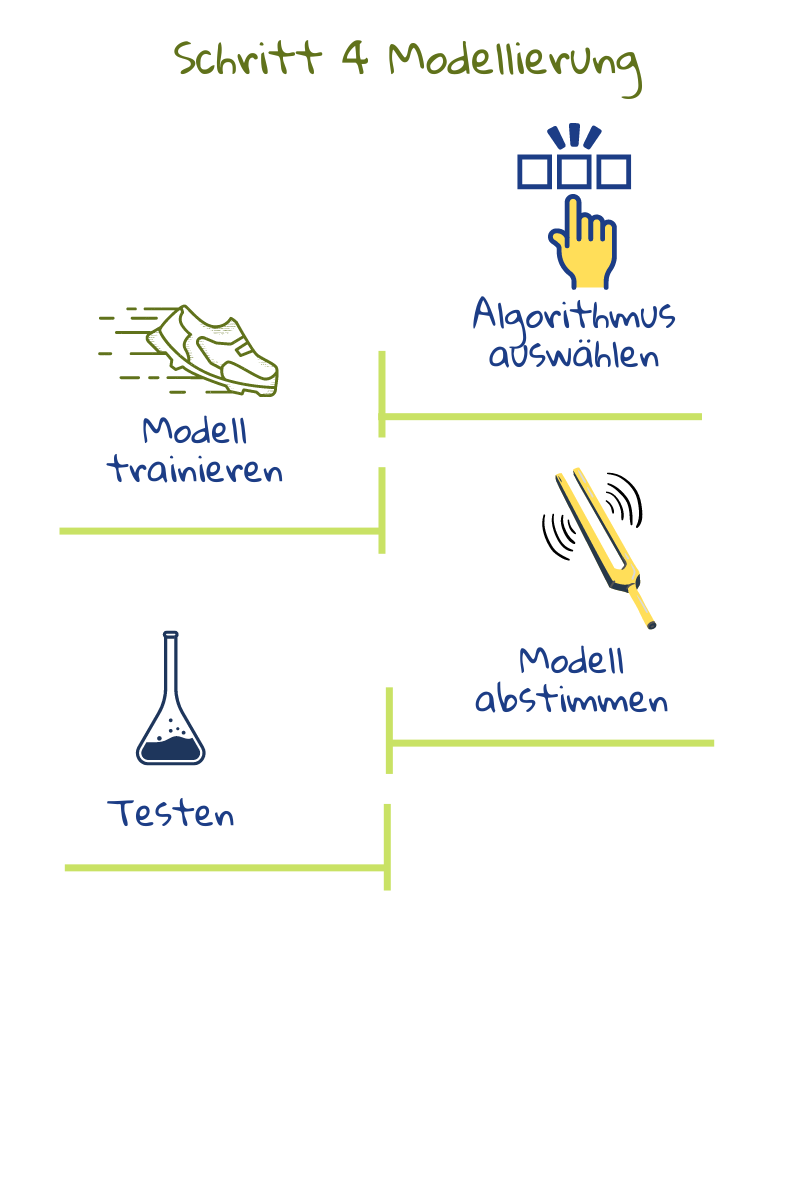

4) Modellierung

In diesem Schritt werden Algorithmen verwendet, um Muster in den Daten zu extrahieren und Modelle zu erstellen. Normalerweise werden verschiedene Algorithmen getestet, um zu sehen, was am besten funktioniert. Diese Modelle können dann eingesetzt werden, um Vorhersagen für neue Daten zu treffen.

In diesem Schritt werden Algorithmen verwendet, um Muster in den Daten zu extrahieren und Modelle zu erstellen. Normalerweise werden verschiedene Algorithmen getestet, um zu sehen, was am besten funktioniert. Diese Modelle können dann eingesetzt werden, um Vorhersagen für neue Daten zu treffen.

In den meisten Projekten zeigen die ersten Modelle Probleme in den Daten auf, die eine Feedbackschleife zwischen den Schritten 2 und 3 erfordern.2. Solange eine starke Korrelation zwischen den Merkmalen der Daten und dem Ausgabewert besteht, ist es sehr wahrscheinlich, dass ein Algorithmus für maschinelles Lernen gute Vorhersagen erzeugt.

Diese Algorithmen verwenden fortschrittliche statistische und rechnerische Techniken, um Daten zu verarbeiten. Die Programmierenden müssen die Einstellungen anpassen und verschiedene Algorithmen ausprobieren, um die besten Ergebnisse zu erzielen. Nehmen wir eine Anwendung zur Erkennung von Betrug. Ein falsch-positiver Befund liegt vor, wenn ein Lernender, der nicht geschummelt hat, markiert wird. Ein falsch-negatives Ergebnis liegt vor, wenn ein Lernender, der geschummelt hat, nicht entdeckt wird. Systementwickelnde können das Modell so abstimmen, dass entweder falsch-positive Ergebnisse, bei denen einige Betrugsfälle übersehen werden könnten, oder falsch-negative Ergebnisse, bei denen sogar zweifelhafte Fälle markiert werden, minimiert werden5 . Die Abstimmung hängt also davon ab, was das System leisten soll.

5) Auswertung

Während der Modellierungsphase kann jedes Modell auf die Genauigkeit der Vorhersage im Trainingsdatensatz abgestimmt werden. Dann werden die Modelle auf dem Testdatensatz getestet und ein Modell für die Verwendung ausgewählt. Dieses Modell wird auch dahingehend bewertet, ob es den pädagogischen Anforderungen entspricht: Werden die in Schritt 1 festgelegten Ziele erreicht? Gibt es unvorhergesehene Probleme? Ist die Qualität gut? Könnte etwas verbessert oder anders gemacht werden? Ist eine Umgestaltung erforderlich? Das Hauptziel ist die Entscheidung, ob die Anwendung in Schulen eingesetzt werden kann. Wenn nicht, beginnt der ganze Prozess von vorne2.

Während der Modellierungsphase kann jedes Modell auf die Genauigkeit der Vorhersage im Trainingsdatensatz abgestimmt werden. Dann werden die Modelle auf dem Testdatensatz getestet und ein Modell für die Verwendung ausgewählt. Dieses Modell wird auch dahingehend bewertet, ob es den pädagogischen Anforderungen entspricht: Werden die in Schritt 1 festgelegten Ziele erreicht? Gibt es unvorhergesehene Probleme? Ist die Qualität gut? Könnte etwas verbessert oder anders gemacht werden? Ist eine Umgestaltung erforderlich? Das Hauptziel ist die Entscheidung, ob die Anwendung in Schulen eingesetzt werden kann. Wenn nicht, beginnt der ganze Prozess von vorne2.

6) Einsatz

Der letzte Schritt dieses Prozesses besteht darin, herauszufinden, wie die datenbasierte Anwendung in das Schulsystem integriert werden kann, um den größtmöglichen Nutzen zu erzielen – sowohl im Hinblick auf die technische Infrastruktur als auch auf die Unterrichtspraxis.

Der letzte Schritt dieses Prozesses besteht darin, herauszufinden, wie die datenbasierte Anwendung in das Schulsystem integriert werden kann, um den größtmöglichen Nutzen zu erzielen – sowohl im Hinblick auf die technische Infrastruktur als auch auf die Unterrichtspraxis.

Auch wenn dies der letzte Schritt ist, ist der gesamte Prozess iterativ. Nach der Einführung sollte das Modell regelmäßig überprüft werden, um festzustellen, ob es für den jeweiligen Kontext noch relevant ist. Der Bedarf, die Prozesse oder die Art der Datenerfassung könnten sich ändern und sich auf die Ergebnisse des Systems auswirken. Daher sollte die Anwendung bei Bedarf überprüft und aktualisiert werden. Das System sollte kontinuierlich auf seine Auswirkungen auf das Lernen, Lehren und Bewerten überwacht werden6.

In den ethischen Richtlinien für die Nutzung von KI und Daten durch Pädagogen wird betont, dass die Schule während des gesamten Lebenszyklus des KI-Systems mit dem Unternehmen, das die KI-Dienstleistung anbietet, in Kontakt bleiben sollte, und zwar bereits vor der Implementierung. Sie sollte eine klare technische Dokumentation verlangen und bei unklaren Punkten um Klärung bitten. Es sollte eine Vereinbarung über Support und Wartung getroffen werden und es sollte sichergestellt werden, dass die anbietende Firma alle rechtlichen Verpflichtungen einhält6.

In den ethischen Richtlinien für die Nutzung von KI und Daten durch Pädagogen wird betont, dass die Schule während des gesamten Lebenszyklus des KI-Systems mit dem Unternehmen, das die KI-Dienstleistung anbietet, in Kontakt bleiben sollte, und zwar bereits vor der Implementierung. Sie sollte eine klare technische Dokumentation verlangen und bei unklaren Punkten um Klärung bitten. Es sollte eine Vereinbarung über Support und Wartung getroffen werden und es sollte sichergestellt werden, dass die anbietende Firma alle rechtlichen Verpflichtungen einhält6.

Hinweis: Sowohl die hier aufgeführten Schritte als auch die Abbildungen sind an die in 2 beschriebenen Phasen und Aufgaben von CRISP-DM Datascience (basierend auf Abbildung 3 in Chapman, Clinton, Kerber, et al. 1999) angepasst.

1 Du Boulay, B., Poulovasillis, A., Holmes, W., Mavrikis, M., Artificial Intelligence And Big Data Technologies To Close The Achievement Gap,in Luckin, R., ed. Enhancing Learning and Teaching with Technology, London: UCL Institute of Education Press, pp. 256–285, 2018.

2 Kelleher, J.D, Tierney, B, Data Science, London, 2018.

3 Hutchinson, B., Smart, A., Hanna, A., Denton, E., Greer, C., Kjartansson, O., Barnes, P., Mitchell, M., Towards Accountability for Machine Learning Datasets: Practices from Software Engineering and Infrastructure, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, Association for Computing Machinery, New York, 2021.

4 Barocas, S., Hardt, M., Narayanan, A., Fairness and machine learning Limitations and Opportunities, 2022.

5 Schneier, B., Data and Goliath: The Hidden Battles to Capture Your Data and Control Your World, W. W. Norton & Company, 2015.

6 Ethical guidelines on the use of artificial intelligence and data in teaching and learning for educators, European Commission, October 2022.