Lernen managen

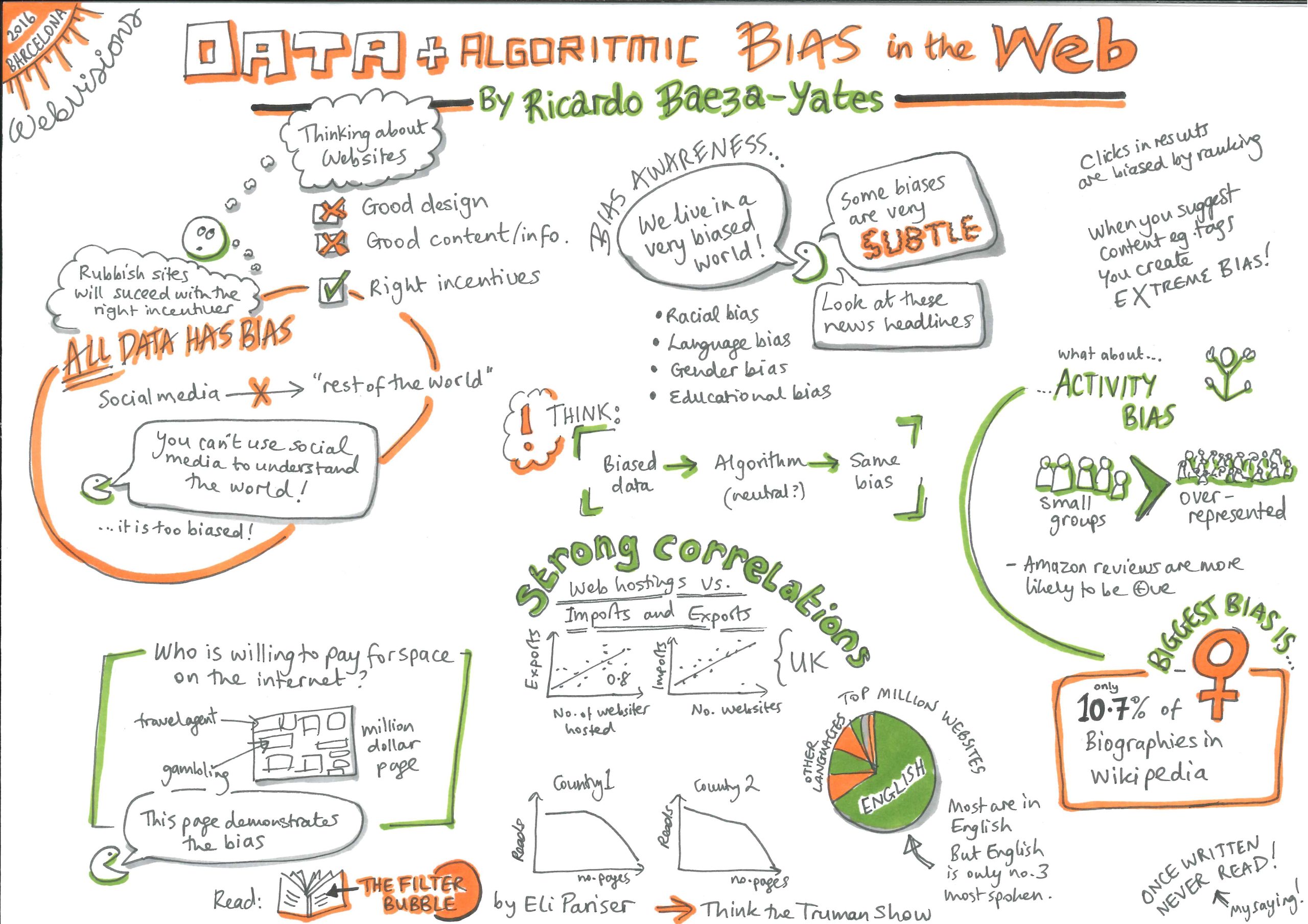

19 Probleme mit Daten: Vorurteile und Fairness

Bei Vorurteilen handelt es sich um Voreingenommenheiten gegenüber einer Identität. Egal ob gut oder schlecht, absichtlich oder unabsichtlich1. Fairness ist das Gegengewicht zu diesen Vorurteilen – und mehr als das: Sie ist dann gegeben, wenn jeder Mensch unabhängig von seiner Identität und seiner Situation fair behandelt wird. Es müssen klare Verfahren festgelegt und befolgt werden, um sicherzustellen, dass jeder gleich behandelt wird und gleichen Zugang zu Chancen hat1.

Menschenbasierte Systeme sind oft mit Vorurteilen und Diskriminierung behaftet: Jeder Mensch hat seine eigenen, einzigartigen Meinungen und Vorurteile. Auch sie sind Black Boxes, deren Entscheidungen und Meinungen schwer zu verstehen sein können. Aber wir haben Strategien entwickelt und Strukturen geschaffen, um auf solche Praktiken zu achten und diese zu hinterfragen.

Automatisierte Systeme werden manchmal als das Allheilmittel gegen menschliche Subjektivität angepriesen: Algorithmen beruhen auf Zahlen, wie können sie da Vorurteile haben? Algorithmen, die unter anderem auf fehlerhaften Daten beruhen, können nicht nur bestehende Vorurteile in Bezug auf Geschlecht, ethnische Herkunft, Kultur oder Behinderung aufgreifen und erlernen, sondern sie können bestehende Vorurteile sogar noch verstärken1,2,3. Erschwerend kommt hinzu, dass sie selbst dann, wenn sie nicht hinter Firmenmauern eingesperrt sind, nicht zur Erklärung ihres Handelns herangezogen werden können, da einige Systeme wie die auf tiefen neuronalen Netzen (Deep Neural Networks) basierenden Systeme von Natur aus nicht erklärbar sind.

Beispiele für Vorurteile in KI-Systemen in der Bildung

- Wenn Programmierende regelbasierte Systeme programmieren, können sie ihre persönlichen Vorurteile und Stereotypen in das System einbringen1.

- Ein datengestützter Algorithmus kann zu dem Schluss kommen, einem Mädchen keine MINT-Karriere vorzuschlagen, weil die Zahl der weiblichen Studierenden in den Daten über MINT-Absolventen geringer ist. Ist die geringere Anzahl von Mathematikerinnen auf vorhandene Stereotypen und gesellschaftliche Normen zurückzuführen oder liegt es an einer inhärenten Eigenschaft des Frauseins? Algorithmen haben keine Möglichkeit, zwischen diesen beiden Situationen zu unterscheiden. Da die vorhandenen Daten vorhandene Stereotypen widerspiegeln, reproduzieren die Algorithmen, mit denen sie trainiert werden, die bestehenden Ungleichheiten und soziale Dynamik4. Wenn solche Empfehlungen umgesetzt werden, werden sich außerdem mehr Mädchen für Nicht-MINT-Fächer entscheiden, und die neuen Daten werden dies widerspiegeln – ein Fall von selbsterfüllender Prophezeiung3.

- Schülerinnen und Schüler aus einer Kultur, die im Trainingsdatensatz unterrepräsentiert ist, haben möglicherweise unterschiedliche Verhaltensmuster und unterschiedliche Arten, Motivation zu zeigen. Wie würde ein Learning Analytics-System Statistiken für sie berechnen? Wenn die Daten nicht für alle Kategorien von Lernenden repräsentativ sind, könnten Systeme, die basierend auf diesen Daten trainiert wurden, die Minderheiten benachteiligen, deren Verhaltenstendenzen nicht dem entsprechen, worauf das Programm optimiert wurde. Wenn wir nicht aufpassen, werden Lernalgorithmen auf der Grundlage der Mehrheitskultur verallgemeinern, was zu einer hohen Fehlerquote bei Minderheitengruppen führt4,5. Solche Entscheidungen könnten diejenigen entmutigen, die sowohl Diversität, Kreativität und einzigartige Talente einbringen könnten, als auch diejenigen, die andere Erfahrungen, Interessen und Motivationen haben2.

- Ein britischer Lernender, der von einer amerikanischen Aufsatzkorrektur-Software beurteilt wird, würde für seine Rechtschreibfehler bestraft werden. Die lokale Sprache, Änderungen in der Rechtschreibung und im Akzent, die lokale Geografie und Kultur sind für Systeme, die für ein anderes Land und einen anderen Kontext entwickelt und trainiert wurden, immer problematisch.

- Manche Lehrkräfte verbieten Ausdrücke, die in einer bestimmten Klasse oder Region gebräuchlich sind, entweder absichtlich oder aufgrund voreingenommener sozialer Assoziationen. Wenn eine Software für die Bewertung von Aufsätzen mit Aufsätzen trainiert wird, die von diesen Lehrkräften benotet wurden, wird sie die gleichen Voreingenommenheiten aufweisen.

- Systeme für maschinelles Lernen benötigen eine Zielvariable und Proxys, für die sie optimiert werden müssen. Nehmen wir an, die Prüfungsergebnisse in der weiterführenden Schule würden stellvertretend für die akademischen Leistungen herangezogen werden. Die Systeme werden nun ausschließlich darauf trainiert, Muster zu verstärken, die mit Schülerinnen und Schülern übereinstimmen, die unter dem Stress und in dem eingeschränkten Kontext von Prüfungssituationen gute Leistungen erbringen. Diese Systeme werden versuchen, die Testergebnisse und nicht das Gesamtwissen zu verbessern, wenn sie den Lernenden Ressourcen und Übungsaufgaben empfehlen. Auch wenn dies in vielen heutigen Klassenzimmern der Fall sein mag, ermöglicht der traditionelle Lehransatz zumindest mehrere Ziele zu verfolgen4.

- Adaptive Lernsysteme schlagen den Schülerinnen und Schülern Ressourcen vor, um einen Mangel an Fähigkeiten oder Wissen zu beheben. Wenn diese Ressourcen gekauft werden müssen oder eine Internetverbindung zu Hause erfordern, dann ist das nicht fair gegenüber den Lernenden, die nicht die Mittel haben, den Empfehlungen zu folgen: „Wenn ein Algorithmus einem Schüler oder einer Schülerin Tipps, nächste Maßnahmen oder Ressourcen vorschlägt, müssen wir prüfen, ob die Hilfeleistung nicht unfair ist, weil eine Gruppe systematisch keine nützliche Hilfe erhält, was diskriminierend ist”2.

- Das Konzept der Personalisierung des Unterrichts entsprechend dem aktuellen Wissensstand und den Vorlieben des Lernenden könnte an sich schon eine Verzerrung darstellen1. Halten wir diesen Schüler oder diese Schülerin nicht auch davon ab, neue Interessen zu entwickeln und Alternativen zu erkunden? Würde sie das nicht eindimensional machen und ihre allgemeinen Fähigkeiten und ihr Wissen sowie ihren Zugang zu Möglichkeiten einschränken?

Was kann die Lehrkraft tun, um die Auswirkungen von KI-Voreingenommenheit zu verringern?

Wissenschaftlerinnen und Wissenschaftler schlagen verschiedene Möglichkeiten zur Verringerung von Vorurteilen vor und analysieren sie. Aber nicht alle Methoden sind einfach umzusetzen. Hinzu kommt, dass es bei Fairness um viel mehr geht, als nur um den Abbau von Vorurteilen.

Wenn beispielsweise die vorhandenen Daten voller Stereotypen sind, „sind wir dann verpflichtet, die Daten zu hinterfragen und unsere Systeme so zu gestalten, dass sie einer bestimmten Vorstellung von gerechtem Verhalten entsprechen, unabhängig davon, ob diese Vorstellung durch die uns derzeit zur Verfügung stehenden Daten gestützt wird oder nicht?“4. Methoden stehen immer in einem Spannungs- und Widerspruchsverhältnis zueinander, und einige Maßnahmen, die eine Art von Verzerrung reduzieren, können eine andere Verzerrung verursachen!

Was kann eine Lehrkraft also tun?

- Fragen Sie die Verkäufer: Bevor Sie sich für ein KI-System entscheiden, sollten Sie sich erkundigen, mit welchen Datensätzen das System trainiert wurde, wo, von wem und für wen das System konzipiert und entwickelt wurde und wie es bewertet wurde.

- Akzeptieren Sie nicht einfach die Statistiken, die Ihnen präsentiert werden. Eine Gesamtgenauigkeit von z. B. „5 % Fehler” kann darüber hinwegtäuschen, dass ein Modell für eine Minderheitengruppe erschreckend schlecht abschneidet4.

- Sehen Sie sich die Dokumentation an: Welche Maßnahmen wurden ergriffen, um Vorurteile zu erkennen und zu bekämpfen und Fairness zu gewährleisten1?

- Informieren Sie sich über die Entwicklerfirma: Handelt es sich ausschließlich um Informatik-Expertinnen und -Experten oder waren Bildungsforschende und Lehrkräfte an allen Schritten des Prozesses beteiligt? Basiert das System ausschließlich auf maschinellem Lernen oder wurden Lerntheorie und -praxis integriert2?

- Bevorzugen Sie transparente, offene Lernmodelle, die Ihnen die Möglichkeit geben, Entscheidungen zu überstimmen2: Viele KI-Modelle für Bildungskontexte haben ein flexibles Design, bei dem Lehrendenen oder sogar Lernenden die Entscheidungen der Maschine überwachen, um Erklärungen bitten oder sie komplett ignorieren können.

- Achten Sie auf die Zugänglichkeit des Produkts: Ist es für jeden in gleicher Weise zugänglich, insbesondere auch für Lernende mit Behinderungen oder besonderen pädagogischen Bedürfnissen1?

- Achten Sie auf die kurz- und langfristigen Auswirkungen des Einsatzes einer Technologie auf Ihre Schülerinnen und Schülern und den Unterricht und seien Sie bereit, Hilfe anzubieten, wenn dies notwendig ist.

Trotz dieser Probleme KI-basierter Technologien gibt es Grund, optimistisch in die Zukunft der KI in Bildungskontexten zu blicken:

- Mit zunehmendem Bewusstsein für diese Themen werden Methoden zur Erkennung und Korrektur von Vorurteilen erforscht und erprobt.

- Regel- und datenbasierte Systeme mit einem gewissen Grad an Erklärbarkeit bringen verborgene Vorurteile in bisherigen pädagogischen Praktiken ans Licht. Indem sie uns zwingen, unsere Gedanken und Prozesse zu artikulieren, zwingen sie uns dazu, unsere Annahmen zu überprüfen und damit aufzuräumen.

- Dank des Anpassungspotenzials von KI-Systemen könnten wir viele Aspekte der Bildung individuell gestalten. Die Ressourcen könnten auf das Wissen und die Erfahrungen jeder einzelnen Lernenden abgestimmt werden. Sie können möglicherweise lokale Gemeinschaften und Kulturgüter einbeziehen und spezifische lokale Bedürfnisse erfüllen2.

1 Ethical guidelines on the use of artificial intelligence and data in teaching and learning for educators, European Commission, October 2022.

2 U.S. Department of Education, Office of Educational Technology, Artificial Intelligence and Future of Teaching and Learning: Insights and Recommendations, Washington, DC, 2023.

3 Kelleher, J.D, Tierney, B, Data Science, MIT Press, London, 2018.

4 Barocas, S., Hardt, M., Narayanan, A., Fairness and machine learning Limitations and Opportunities, 2022.

5 Milano, S., Taddeo, M., Floridi, L., Recommender systems and their ethical challenges, AI & Soc 35, 957–967, 2020.