À propos des IA génératives

39 IA dégénérative – Partie 1

L’IA générative, en tant qu’outil de deep learning, a hérité de tous les problèmes éthiques et sociaux liés aux modèles d’apprentissage des machines :

Menaces pour la vie privée : les fournisseurs d’IA générative, comme ceux des autres technologies d’IA, collectent tous types de données utilisateurs qui sont ensuite partagées avec des tiers. La politique de confidentialité d’OpenAI reconnait supprimer les données utilisateurs sur demande mais pas les prompts des utilisateurs, qui peuvent eux-mêmes contenir des informations sensibles permettant de remonter jusqu’à l’utilisateur1.

Il est également possible que certaines personnes révèlent des informations plus sensibles dans le cadre d’une conversation en apparence humaine2. Cela est particulièrement pertinent lorsqu’il s’agit d’étudiants qui utilisent directement des systèmes d’IA générative. En imitant si efficacement le langage humain, et notamment en se mettant à portée des enfants, cette technologie peut avoir « des effets psychologiques inconnus sur les apprenants, ce qui soulève des inquiétudes concernant leur développement cognitif et leur bien-être émotionnel, en présentant un risque potentiel de manipulation3. »

Transparence et explicabilité : même les fournisseurs de modèles d’IA générative supposément ouverts peuvent se montrer méfiants à l’égard des éléments et des méthodes utilisés pour entrainer et ajuster ces modèles. En outre, pour les modèles très profonds comprenant des millions de paramètres, la pondération assignée à chaque paramètre et la manière dont ils s’assemblent pour parvenir à un résultat spécifique ne peuvent pas être expliquées3.

La forme et le contenu du résultat peuvent grandement varier, même lorsque les prompts ou l’historique des utilisateurs sont très similaires2. Si deux étudiants reçoivent le même exercice, ils peuvent non seulement parvenir à des résultats extrêmement différents mais il serait également impossible d’expliquer ces différences. Le choix du modèle, et le fait que sa version soit payante ou non, influent aussi sur le résultat. Cela a un impact sur ce que les étudiants apprennent et sur l’équité du processus, lorsque leurs résultats sont notés. Pour autant, bannir l’utilisation de ces modèles serait également problématique puisque cela consoliderait l’écart entre les apprenants qui peuvent y accéder et ceux qui ne peuvent pas1.

Homogénéité : si la variabilité des résultats et l’absence d’explication peuvent générer des inquiétudes, il en va de même en ce qui concerne le problème de la normalisation et de l’homogénéisation. Étant entrainés grâce à des données Internet, les systèmes d’IA générative mettent plus en avant certaines opinions et certaines valeurs culturelles que d’autres, ce qui a pour effet de limiter l’exposition de l’apprenant à des points de vue variés ainsi que sa capacité de réflexion critique3. « Chaque ensemble de données, même ceux qui contiennent des milliards de combinaisons image-texte recueillies sur Internet, intègre des visions du monde et le découpe en catégories qui peuvent se révéler très problématiques4. »

Par exemple, sur Wikipedia, une ressource populaire pour les ensembles de données d’entraînement, la grande majorité des créateurs de contenus sont des hommes5.

En ce qui concerne les modèles de fondation6 conçus pour être adaptés à toutes sortes de tâches en aval, cette tendance à l’homogénéisation est plus forte que pour les autres modèles de machine learning. Toutefois, la manière dont ces modèles sont adaptés semble jouer un rôle important sur le fait que l’homogénéisation soit renforcée, affaiblie ou maintenue au même niveau7.

« ChatGPT est « multilingue mais monoculturel » car il a été entrainé sur la base de « textes anglais, en intégrant les biais culturels et les valeurs qu’ils comprennent, avant d’être aligné sur les valeurs d’un groupe relativement restreint d’entrepreneurs américains ». Si un enseignant utilise l’IA générative pour noter les copies de ses élèves, est-ce que, en fin de compte, ce qui sera noté ne sera pas simplement la capacité de l’étudiant à se conformer à cette vision du monde, à cette manière de penser, de connaitre et d’utiliser la langue1 ?

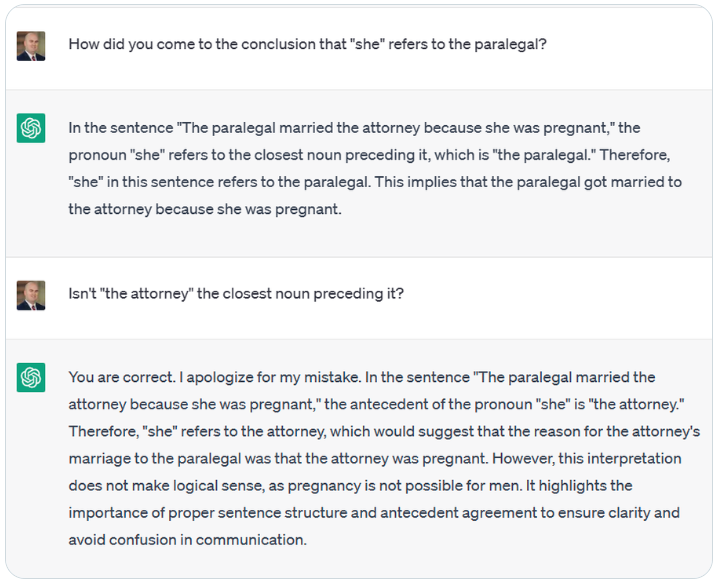

Biais, stéréotypes et inclusivité : les systèmes d’IA générative peuvent inclure de nombreux biais et stéréotypes. Par exemple, dans la phrase « The paralegal married the attorney because she was pregnant », il a été demandé à ChatGPT qui le pronom « she » désignait. ChatGPT a répondu que « she » désignait le/la « paralegal » (assistant juridique), en cherchant à tout prix des raisons pour justifier le fait que « she » ne pouvait pas désigner « attorney » (avocate ).

Même si ChatGPT refuse d’écrire du contenu explicitement sexiste ou raciste, il a été montré qu’il était moins réticent à écrire des codes Pythons contenant ce type de contenu1. Il a déjà été prouvé que Codex pouvait également générer du code reflétant différentes sortes de stéréotypes8. BERT associe des phrases désignant des personnes en situation de handicap à des mots négatifs et les personnes souffrant de maladies mentales à la violence armée, au fait d’être sans abri et à la drogue5.

Les modèles texte-image génèrent également des contenus biaisés, notamment ceux qui découlent des données d’entraînement et qui sont liés à « des problèmes de représentation (par exemple, stéréotypes offensants à propos de minorités), de sous-représentation (par exemple, élimination des occurrences d’un genre pour certains postes) et de surreprésentation (par exemple, adoption par défaut de points de vue anglocentriques)6,4.

On trouve également des formes plus subtiles de négativité, comme la déshumanisation de groupes de personnes et la manière dont certains groupes sont désignés. Les Grands Modèles de Langages qui perpétuent ces problèmes affectent non seulement les utilisateurs concernés, mais, quand ces éléments sont distribués automatiquement via des forums de discussion et des commentaires, ils deviennent également des données d’entraînement qui reflètent la « nouvelle réalité » pour une nouvelle génération de LLM5. Malheureusement, il revient ensuite aux enseignants de trier les résultats générés et d’intervenir immédiatement lorsqu’un enfant accède à un tel contenu, qu’il soit lui-même directement touché par le contenu ou qu’il intègre et propage ce biais.

Modération des contenus : comme pour les moteurs de recherche et les systèmes de recommandation, l’IA générative permet de sélectionner les contenus proposés aux utilisateurs. Le contenu qui peut être généré par l’IA générative se base toujours sur les contenus auxquels elle a accès : ce qui est facilement accessible et ce qui est considéré comme adapté par ses créateurs. Leurs points de vue définissent la « réalité » pour les utilisateurs de l’IA générative et influent sur leur agentivité. Ainsi, les enseignants et les apprenants doivent toujours avoir une vision critique des valeurs, des coutumes et des cultures qui forment la structure des images et des textes générés3.

Il convient de ne pas oublier que l’IA générative n’est pas et « ne sera jamais une source de connaissance fiable, peu importe le sujet abordé3. » Afin de lutter contre son effet de filtrage, les apprenants doivent avoir la possibilité de communiquer avec leurs camarades, de discuter avec des personnes occupant des fonctions différentes ou venant de milieux différents, de poser des questions et d’explorer des idéologies, de vérifier la véracité des faits, d’expérimenter par eux-mêmes et d’apprendre de leurs réussites, de leurs erreurs et de toutes leurs expériences. Si, dans le cadre d’une activité, ils doivent suivre des idées proposées par une IA générative pour un projet, un code ou une expérience, une autre activité devrait leur demander de tester leurs propres idées et problématiques, en se référant à des ressources d’apprentissage diversifiées.

Environnement et durabilité : tous les modèles de machine learning nécessitent une forte puissance de traitement et de nombreux centres de données, qui ont un impact environnemental, notamment en ce qui concerne la quantité d’eau requise pour le refroidissement des serveurs9. La puissance informatique requise par les grands modèles de deep learning s’est vue multipliée par 300000 au cours des six dernières années5. L’entraînement des grands modèles de langages peut nécessiter une consommation énergétique considérable et les modèles doivent être hébergés à un endroit, en restant accessibles à distance8. Le réglage de précision des modèles requiert également beaucoup d’énergie et nous ne disposons pas de beaucoup de données en ce qui concerne l’impact environnemental de ce processus5.

Pourtant, si la performance de ces modèles est bien documentée, on aborde rarement le sujet de leur impact environnemental. Même dans le cadre d’analyses coûts-bénéfices, on ne tient pas compte du fait que certaines communautés bénéficient des avantages de ces modèles tandis que d’autres en paient le prix5. En plus d’être injuste, cela n’augure rien de bon pour la viabilité des projets d’IA générative sur le long terme.

Avant que ces modèles soient largement adoptés dans l’enseignement et que les infrastructures et les modes d’enseignement existants soient négligés en faveur de ceux reposant sur l’IA générative, il convient de discuter de la durabilité et de la viabilité sur le long terme de cette transition.

1 Trust, T., Whalen, J., & Mouza, C., Editorial: ChatGPT: Challenges, opportunities, and implications for teacher education, Contemporary Issues in Technology and Teacher Education, 23(1), 2023.

2 Tlili, A., Shehata, B., Adarkwah, M.A. et al, What if the devil is my guardian angel: ChatGPT as a case study of using chatbots in education, Smart Learning Environments, 10, 15 2023.

3 Holmes, W., Miao, F., Guidance for generative AI in education and research, UNESCO, Paris, 2023.

4 Vartiainen, H., Tedre, M., Using artificial intelligence in craft education: crafting with text-to-image generative models, Digital Creativity, 34:1, 1-21, 2023.

5 Bender, E.M., et al, On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT ’21). Association for Computing Machinery, New York, 610–623, 2021.

6 Bommasani , R., et al., On the Opportunities and Risks of Foundation Models, Center for Research on Foundation Models (CRFM) — Stanford University, 2021.

7 Bommasani, R., et al, Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization?, Advances in Neural Information Processing Systems, 2022.

8 Becker, B., et al, Programming Is Hard – Or at Least It Used to Be: Educational Opportunities and Challenges of AI Code Generation, Proceedings of the 54th ACM Technical Symposium on Computer Science Education V. 1 (SIGCSE 2023), Association for Computing Machinery, New York, 500–506, 2023.

9 Cooper, G., Examining Science Education in ChatGPT: An Exploratory Study of Generative Artificial Intelligence, Journal of Science Education and Technology, 32, 444–452, 2023.