Gérer l’éducation

17 Parlons IA : Systèmes basés sur les données – Partie 2

La conception et la mise en œuvre d’un projet centré sur les données pourraient être décomposées en 6 étapes. Il y a beaucoup d’allers et retours entre les étapes et l’ensemble du processus peut devoir être répété plusieurs fois pour qu’il soit parfait.

Pour être efficace en classe, des équipes multidisciplinaires avec des enseignants, des experts pédagogiques et des informaticiens devraient être impliqués dans chaque étape du processus1. Des experts humains sont nécessaires pour identifier le besoin et concevoir le processus, pour concevoir et préparer les données, pour choisir les algorithmes ML, pour interpréter de manière critique les résultats et pour prévoir la façon d’utiliser l’application2.

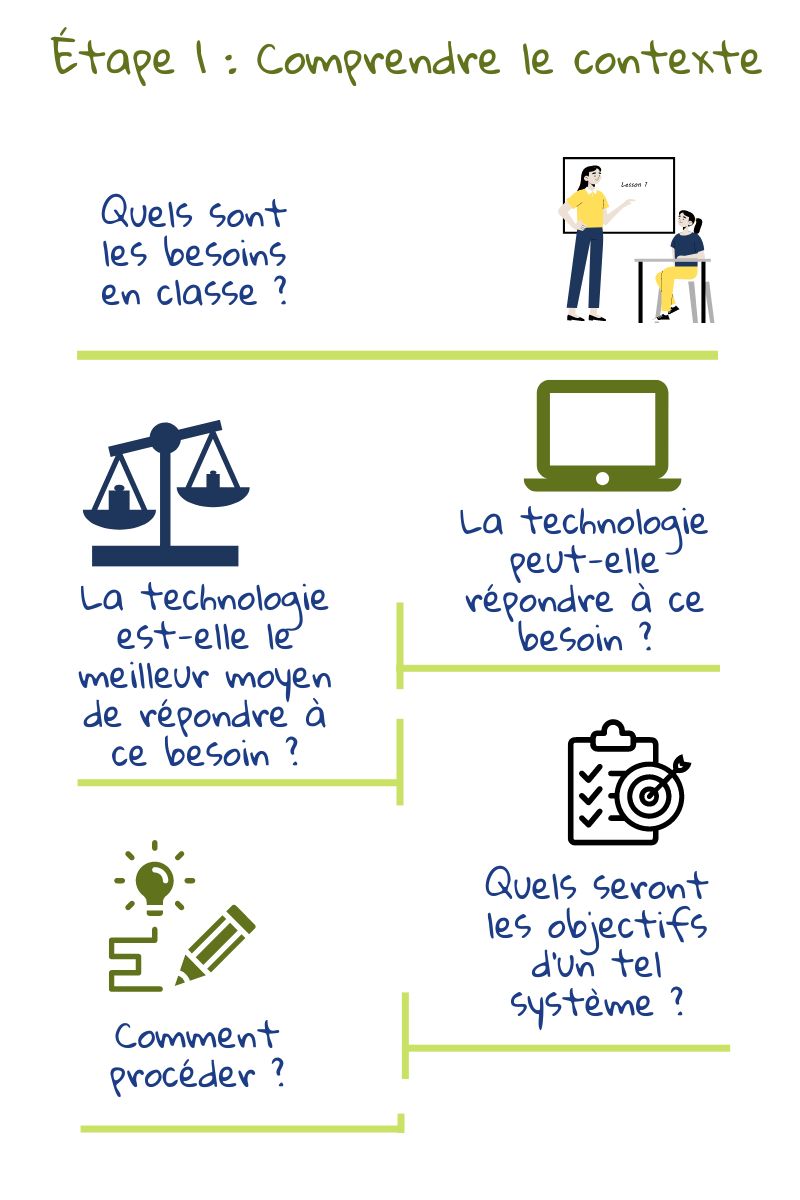

1) Comprendre le contexte éducatif

La première étape de la conception d’un outil AIED consiste à comprendre les besoins de la classe. Une fois les objectifs fixés, il convient de voir comment les atteindre : quels sont les facteurs à prendre en compte et ceux à ignorer. Toute solution basée sur des données est biaisée en faveur des phénomènes qui peuvent être facilement calculés et standardisés3. Ainsi, chaque décision doit être étudiée par les enseignants qui utiliseront l’outil, les experts en pédagogie qui peuvent assurer que toutes les décisions sont fondées sur des théories éprouvées et les informaticiens qui comprennent le fonctionnement des algorithmes.

La première étape de la conception d’un outil AIED consiste à comprendre les besoins de la classe. Une fois les objectifs fixés, il convient de voir comment les atteindre : quels sont les facteurs à prendre en compte et ceux à ignorer. Toute solution basée sur des données est biaisée en faveur des phénomènes qui peuvent être facilement calculés et standardisés3. Ainsi, chaque décision doit être étudiée par les enseignants qui utiliseront l’outil, les experts en pédagogie qui peuvent assurer que toutes les décisions sont fondées sur des théories éprouvées et les informaticiens qui comprennent le fonctionnement des algorithmes.

Il y a beaucoup d’allers-retours entre les deux premières étapes puisque ce qui est possible dépendra également des données disponibles.

De plus, la conception d’outils pédagogiques est également soumise à des lois qui imposent des restrictions sur l’utilisation des données et les types d’algorithmes qui peuvent être utilisés.

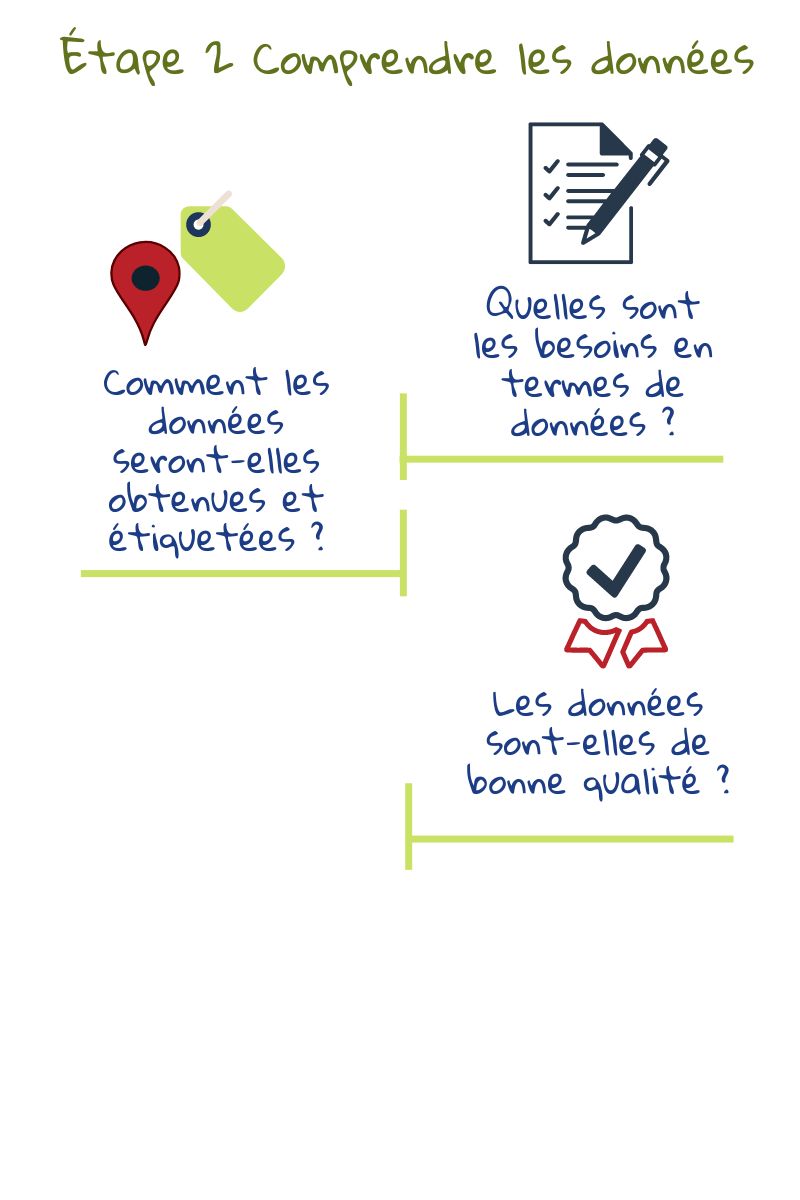

2) Comprendre les données

Une fois les objectifs et les facteurs contributifs identifiés, l’accent est mis sur les données nécessaires, la façon dont elles seront sourcées et étiquetées, la façon dont la confidentialité sera assurée et la façon dont la qualité des données sera mesurée3. Pour qu’une application d’apprentissage automatique soit réussie, les ensembles de données doivent être suffisamment grands, diversifiés et bien étiquetés.

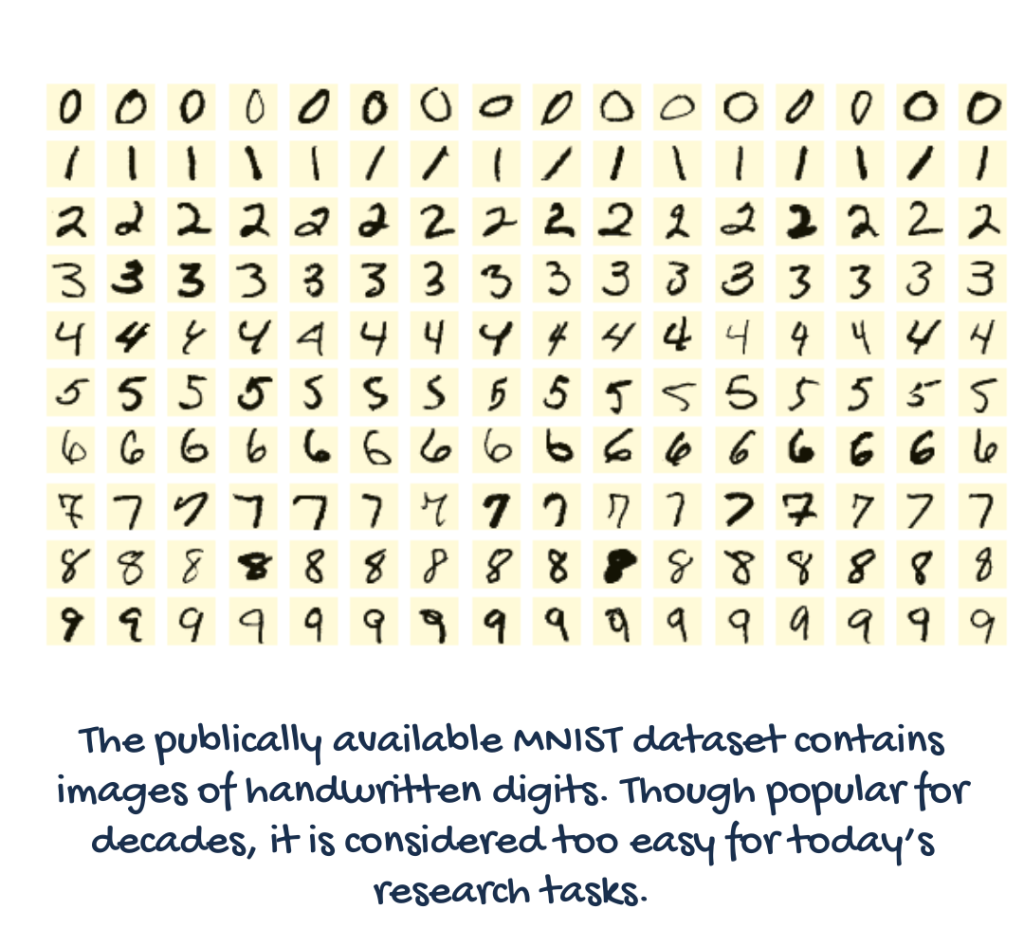

L’apprentissage automatique nécessite des données pour entraîner le modèle et des données sur lesquelles travailler ou prédire. Certaines tâches ML, comme la reconnaissance des visages et des objets, disposent déjà de nombreuses bases de données privées et publiques pour l’entraînement.

S’ils ne sont pas déjà disponibles sous une forme utilisable, les ensembles de données existants peuvent devoir être enrichis ou réétiquetés pour répondre aux besoins du projet. Dans le cas contraire, des ensembles de données dédiés devront peut-être être créés et étiquetés en partant de zéro. Les traces numériques générées par l’étudiant lors de l’utilisation d’une application pourraient également être utilisées comme l’une des sources de données.

Dans tous les cas, les données et les éléments pertinents pour le problème doivent être soigneusement identifiés2. Les éléments non pertinents ou redondants peuvent pousser un algorithme à trouver de faux modèles et compromettre les performances du système2. Puisque la machine ne peut trouver des modèles que dans les données qui lui sont fournies, le choix de l’ensemble de données définit aussi implicitement ce qu’est le problème4. S’il y a beaucoup de données disponibles, un sous-ensemble doit être sélectionné à l’aide de techniques statistiques et les données vérifiées pour éviter les erreurs et les biais.

A titre d’exemple de mauvaises données d’entraînement, dans une histoire datant des débuts de la vision par ordinateur, un modèle a été entraîné à discriminer les images de chars russes et américains. On a découvert plus tard que sa grande précision était due au fait que les chars russes avaient été photographiés par temps nuageux et les chars américains par temps ensoleillé4.

Donc, la qualité de l’ensemble de données choisi doit être vérifiée, en tenant compte de la raison pour laquelle il a été créé, de ce qu’il contient, des processus utilisés pour la collecte, le traitement et l’étiquetage, la distribution et la maintenance.

Les questions clés à poser comprennent Les ensembles de données sont-ils adaptés à

leurs objectifs prévus et Les ensembles de données contiennent-ils des risques cachés qui peuvent rendre les modèles biaisés ou discriminatoires3?

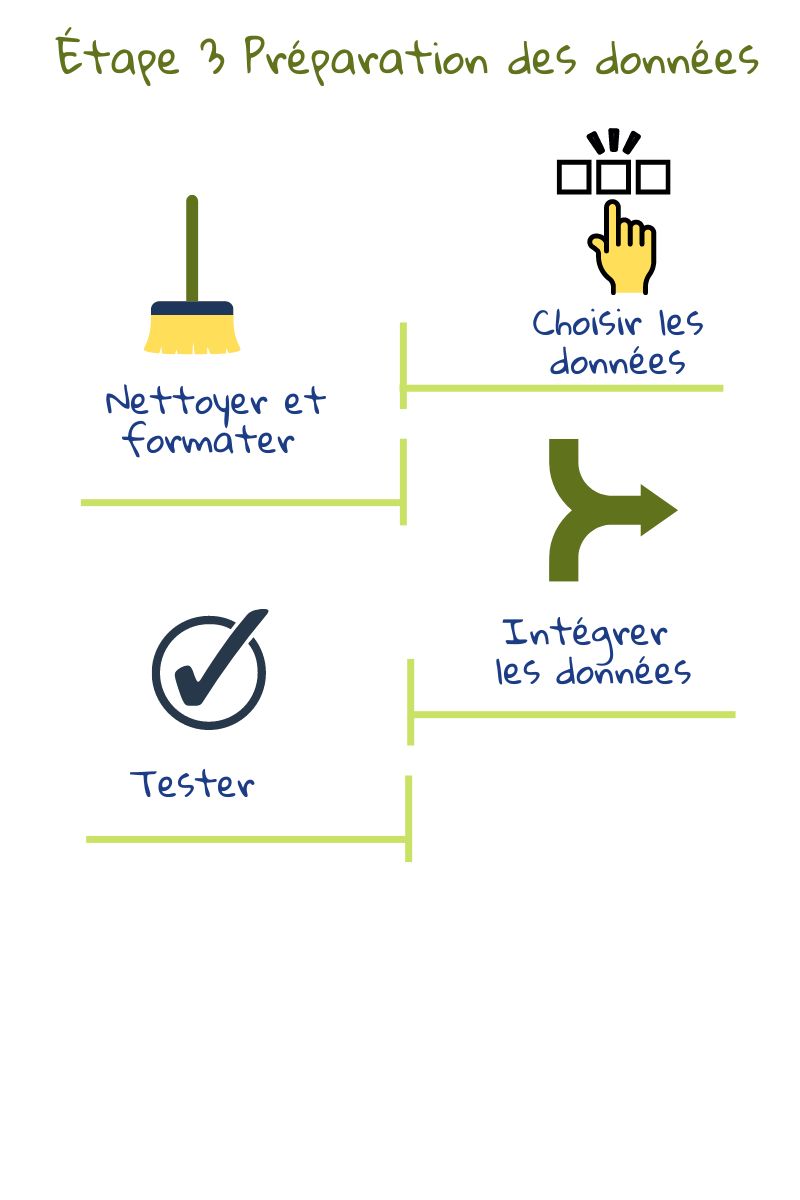

3) Préparation des données

La préparation des données consiste à créer des ensembles de données en fusionnant les données disponibles à différents endroits, en corrigeant les incohérences (par exemple, certaines notes de test pourraient être sur une échelle de 1 à 10 alors que d’autres sont données en pourcentage) et en recherchant les valeurs manquantes ou extrêmes. Ensuite, des tests automatisés pourraient être effectués pour vérifier la qualité des ensembles de données. Cela inclut la vérification des fuites de confidentialité et des corrélations ou stéréotypes imprévus2. Les ensembles de données pourraient également être divisés en ensembles de données de training et de test à ce stade. Le premier est utilisé pour entraîner le modèle et le deuxième pour vérifier ses performances. Faire des tests avec l’ensemble de données d’entraînement reviendrait à donner l’examen la veille pour les devoirs : la performance de l’étudiant à l’examen n’indiquera pas sa compréhension2.

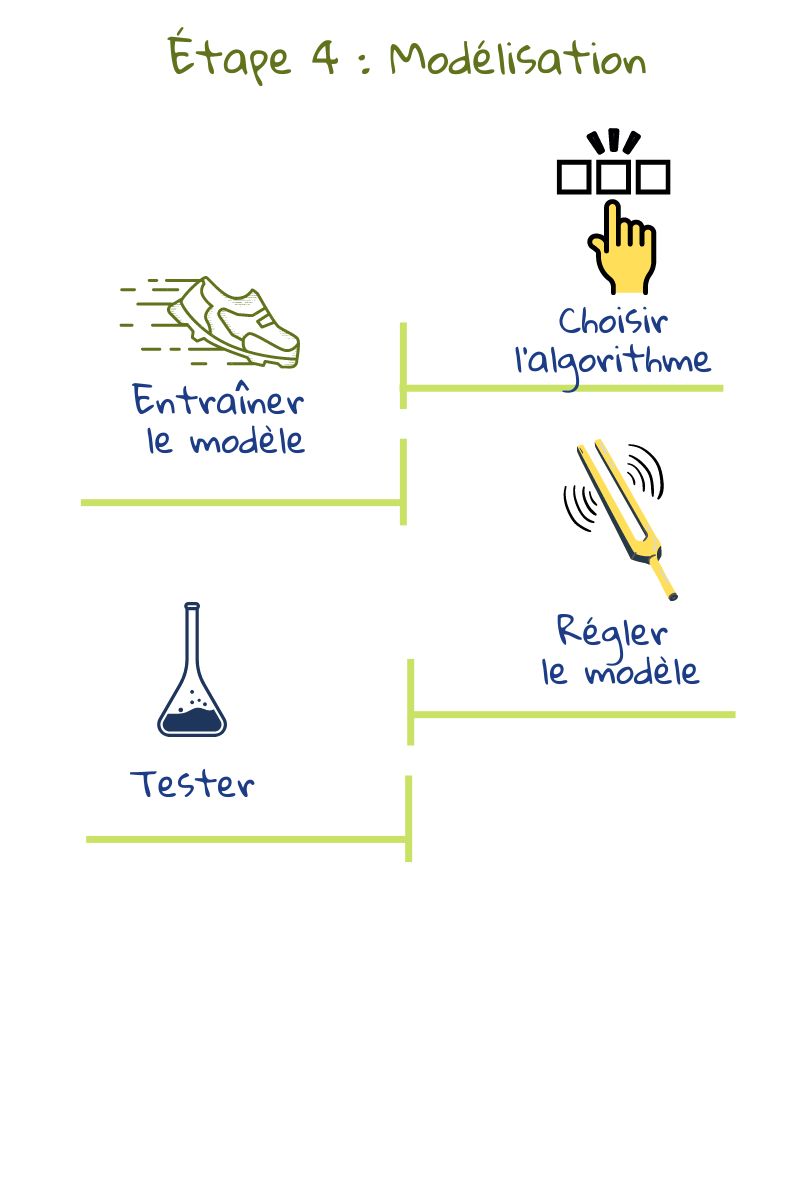

4) Modélisation

Dans cette étape, des algorithmes sont utilisés pour extraire des tendances dans les données et créer des modèles. Habituellement, différents algorithmes sont testés pour voir ce qui fonctionne le mieux. Ces modèles peuvent ensuite être mis à profit pour faire des prédictions sur de nouvelles données.

Dans cette étape, des algorithmes sont utilisés pour extraire des tendances dans les données et créer des modèles. Habituellement, différents algorithmes sont testés pour voir ce qui fonctionne le mieux. Ces modèles peuvent ensuite être mis à profit pour faire des prédictions sur de nouvelles données.

Dans la plupart des projets, les modèles initiaux découvrent des problèmes dans les données appelant des allers-retours entre les étapes 2 et 32. Tant qu’il existe une forte corrélation entre les caractéristiques des données et la valeur de sortie, il est très probable qu’un algorithme d’apprentissage automatique génère de bonnes prédictions.

Ces algorithmes utilisent des techniques statistiques et informatiques avancées pour traiter les données. Les programmeurs doivent ajuster les paramètres et essayer différents algorithmes pour obtenir les meilleurs résultats. Prenons une application qui détecte la tricherie. Un faux positif, c’est lorsqu’un élève qui n’a pas triché est signalé. Un faux négatif, c’est lorsqu’un élève qui a triché n’est pas signalé. Les concepteurs de systèmes peuvent régler le modèle pour minimiser soit les faux positifs, où certains comportements de tricherie pourraient être manqués, soit les faux négatifs, où même les cas douteux sont signalés5. Le réglage dépend donc de ce que nous voulons obtenir du système.

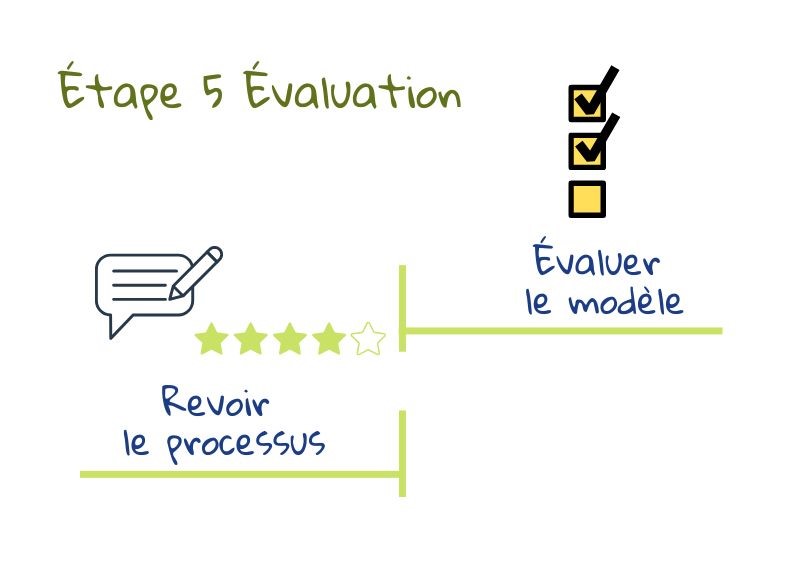

5) Évaluation

Pendant l’étape de modélisation, chaque modèle peut être réglé pour la précision de la prédiction sur l’ensemble de données d’entraînement. Les modèles sont ensuite testés sur l’ensemble de données de test et un modèle est choisi pour être utilisé. Ce modèle est également évalué sur la façon dont il répond aux besoins éducatifs : Les objectifs fixés à l’étape 1 sont-ils atteints ? Y a-t-il des problèmes imprévus ? La qualité est-elle bonne ? Est-ce que certaines parties pourraient être améliorées ou réalisées d’une autre manière ? Une nouvelle conception est-elle nécessaire ? L’objectif principal est de décider si l’application peut être déployée dans les écoles. Si ce n’est pas le cas, tout le processus est recommencé2.

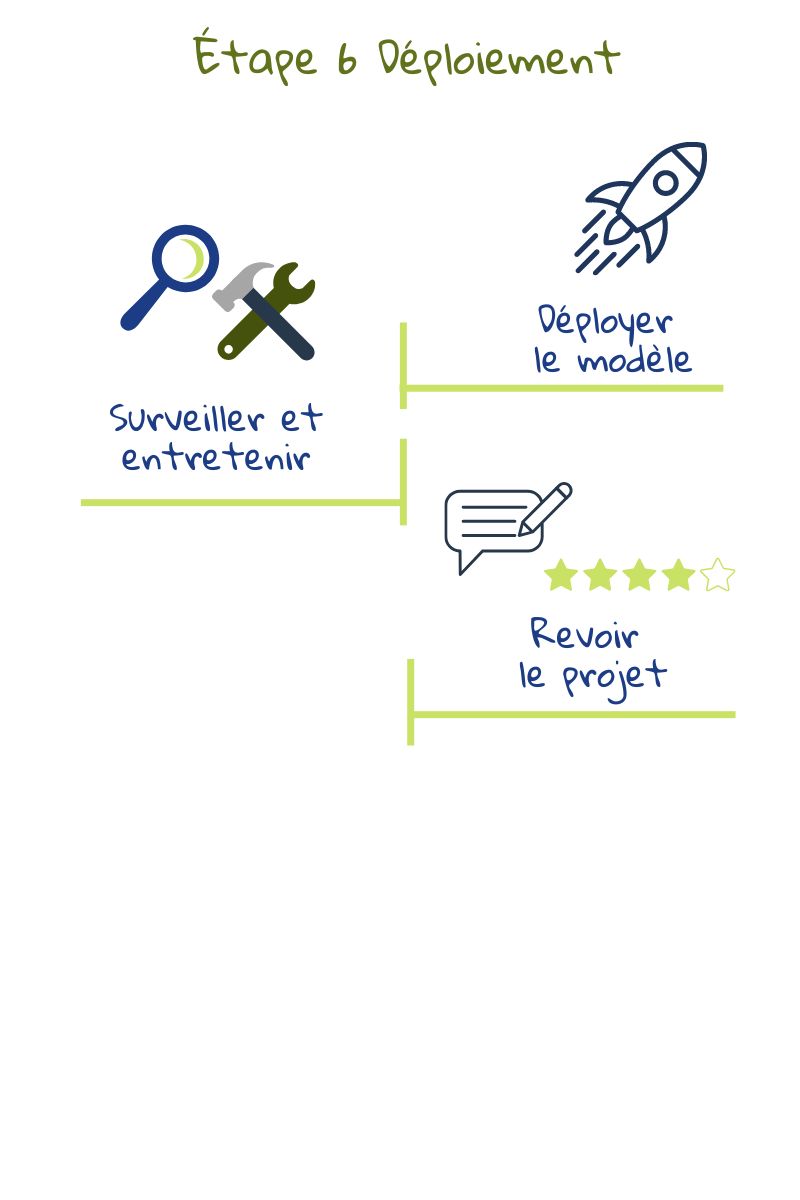

6) Déploiement

La dernière étape de ce processus consiste à voir comment intégrer l’application basée sur les données au système scolaire pour en tirer le maximum d’avantages, tant au niveau de l’infrastructure technique que des pratiques pédagogiques.

La dernière étape de ce processus consiste à voir comment intégrer l’application basée sur les données au système scolaire pour en tirer le maximum d’avantages, tant au niveau de l’infrastructure technique que des pratiques pédagogiques.

Bien que donné comme l’étape finale, l’ensemble du processus est itératif. Après le déploiement, le modèle doit être régulièrement revu pour vérifier s’il est toujours pertinent dans le contexte. Les besoins, les processus ou les modes de saisie des données pourraient changer, ce qui affecterait les résultats du système. L’application doit donc être revue et mise à jour si nécessaire. Le système devrait être surveillé en permanence pour son impact sur l’apprentissage, l’enseignement et l’évaluation6.

Les directives éthiques sur l’utilisation de l’IA et des données pour les éducateurs soulignent que l’école devrait être en contact avec le fournisseur de services d’IA tout au long du cycle de vie du système d’IA, même avant le déploiement. Elle devrait demander une documentation technique claire et demander des éclaircissements sur les points peu clairs. Un accord devrait être conclu pour le support et la maintenance et il faudrait s’assurer que le fournisseur a respecté toutes les obligations légales6.

Note : Tant les étapes énumérées ici que l’illustration sont adaptées des étapes et des tâches de CRISP-DM Datascience (basées sur la figure 3 de Chapman, Clinton, Kerber, et al. 1999) telles que présentées dans 2.

1 Du Boulay, B., Poulovasillis, A., Holmes, W., Mavrikis, M., Artificial Intelligence And Big Data Technologies To Close The Achievement Gap,in Luckin, R., ed. Enhancing Learning and Teaching with Technology, London: UCL Institute of Education Press, pp. 256–285, 2018.

2 Kelleher, J.D, Tierney, B, Data Science, London, 2018.

3 Hutchinson, B., Smart, A., Hanna, A., Denton, E., Greer, C., Kjartansson, O., Barnes, P., Mitchell, M., Towards Accountability for Machine Learning Datasets: Practices from Software Engineering and Infrastructure, Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, Association for Computing Machinery, New York, 2021.

4 Barocas, S., Hardt, M., Narayanan, A., Fairness and machine learning Limitations and Opportunities, 2022.

5 Schneier, B., Data and Goliath: The Hidden Battles to Capture Your Data and Control Your World, W. W. Norton & Company, 2015.

6 Ethical guidelines on the use of artificial intelligence and data in teaching and learning for educators, European Commission, October 2022.